修改配置文件

修改hbase-env.sh

更改前:

将# export HBASE_MANAGES_ZK=true改为export HBASE_MANAGES_ZK=false

表示启动HBase时不启动zookeeper,用户单独启动zookeeper。

更改后:

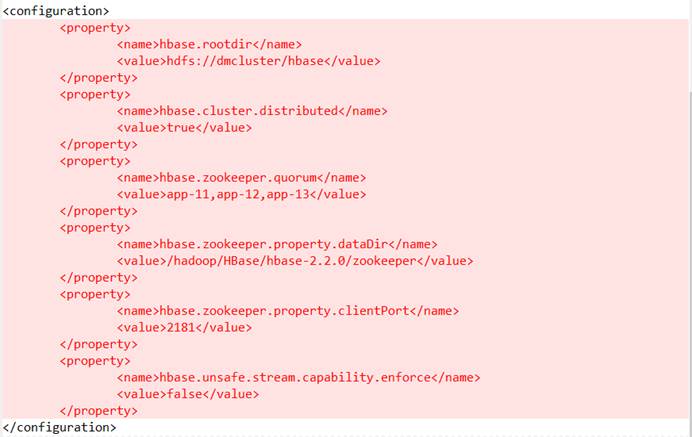

修改hbase-site.xml

更改前:

在hbase-site.xml中添加

<property>

<name>hbase.rootdir</name>

<value>hdfs://dmcluster/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>app-11,app-12,app-13</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/hadoop/HBase/hbase-2.2.0/zookeeper</value>

</property>

<property>

<name>hbase.zookeeper.property.clientPort</name>

<value>2181</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

```

更改后:

## 修改regionservers

更改前:

在regionservers中添加app-11

app-12

app-13

更改后:

## 添加backup-masters文件

文件中只写app-13

# 安装HBase

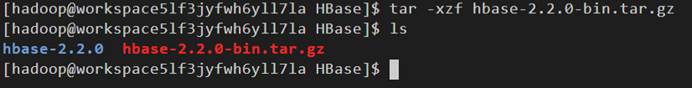

## 下载HBase安装包

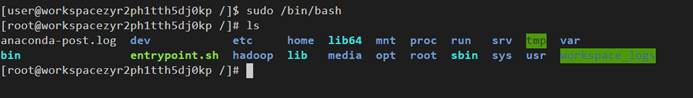

1、以root用户登录

命令:```sudo /bin/bash```

2、创建HBase目录

命令:```mkdir /hadoop/HBase```

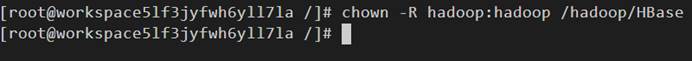

3、将HBase目录下的所有目录改为hadoop所有

命令:```chown hadoop:hadoop /hadoop/HBase```

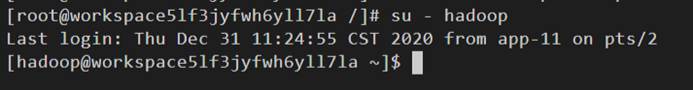

4、以hadoop用户登录

命令:```su - hadoop```

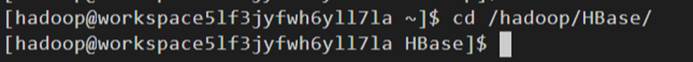

5、进入HBase安装目录

命令:```cd /hadoop/HBase/```

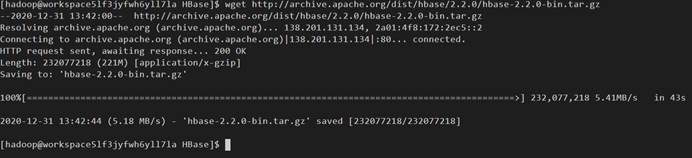

6、下载HBase安装包

命令:```wget http://archive.apache.org/dist/hbase/2.2.0/hbase-2.2.0-bin.tar.gz```

7、解压安装包

命令:```tar -xzf hbase-2.2.0-bin.tar.gz```

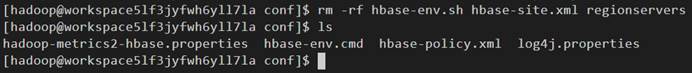

## 修改配置文件

8、进入到配置文件下

命令:```cd hbase-2.2.0/conf/```

9、删除需要修改的配置文件

命令:```rm -rf hbase-env.sh hbase-site.xml regionservers```

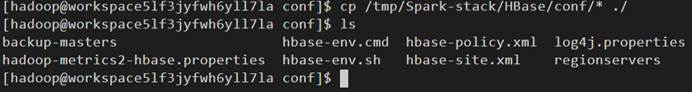

10、将/tmp/Spark-stack/HBase/conf目录下修改好的配置文件拷贝到配置文件中

命令:```cp /tmp/Spark-stack/HBase/conf/* ./```

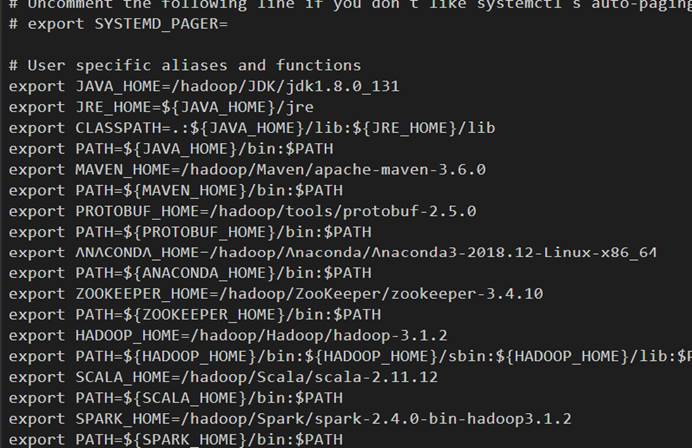

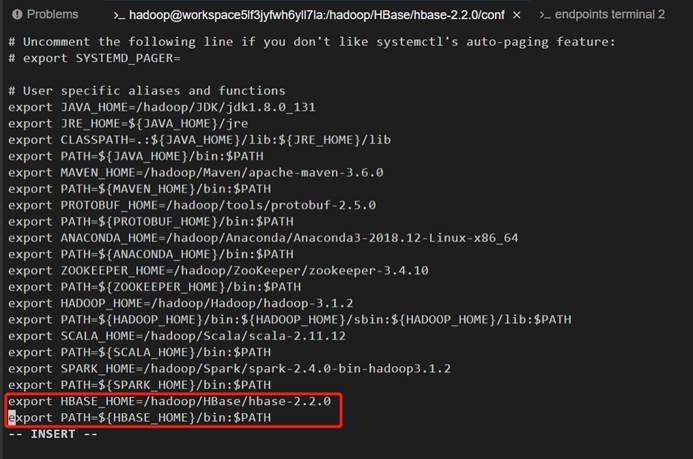

## 修改环境变量

11、打开环境变量

命令:```vi ~/.bashrc```

12、添加```export HBASE_HOME=/hadoop/HBase/hbase-2.2.0

export PATH=${HBASE_HOME}/bin:$PATH```

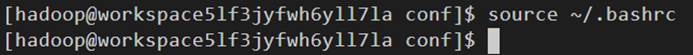

13、使环境变量生效

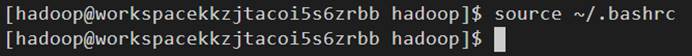

命令:```source ~/.bashrc```

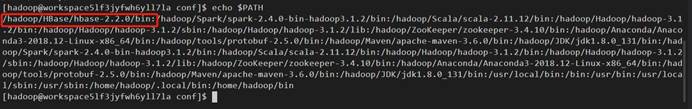

14、查看环境变量是否生效

命令:```echo $PATH```

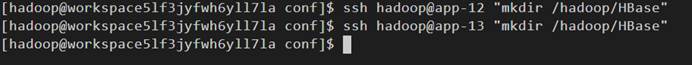

## 在其他的两个机器上安装HBase

15、在app-12和app-13上先创建安装HBase的目录

命令:```ssh hadoop@app-12 "mkdir /hadoop/HBase"```、```ssh hadoop@app-13 "mkdir /hadoop/HBase"```

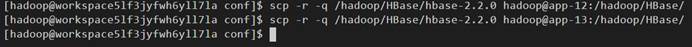

16、将HBsae拷贝到app-12和app-13上

命令:```scp -r -q /hadoop/HBase/hbase-2.2.0 hadoop@app-12:/hadoop/HBase/```、```scp -r -q /hadoop/HBase/hbase-2.2.0 hadoop@app-13:/hadoop/HBase/```

17、将环境变量也拷贝到app-12和app-13上

命令:```scp ~/.bashrc hadoop@app-12:~/```、```scp ~/.bashrc hadoop@app-13:~/```

## 清除工作(清除第一次安装失败之后删除不干净的文件)

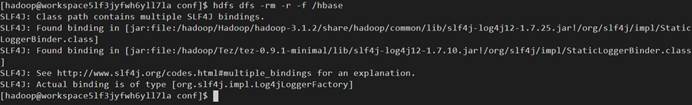

18、清除hdfs中hbase目录,不存在则不需要清除

命令:```hdfs dfs -rm -r -f /hbase```

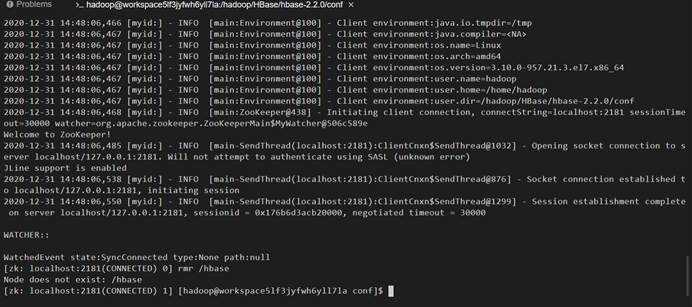

19、清除zookeeper中hbase节点,否则可能出现Master is initializing之类错误

命令:```echo 'rmr /hbase' | zkCli.sh```

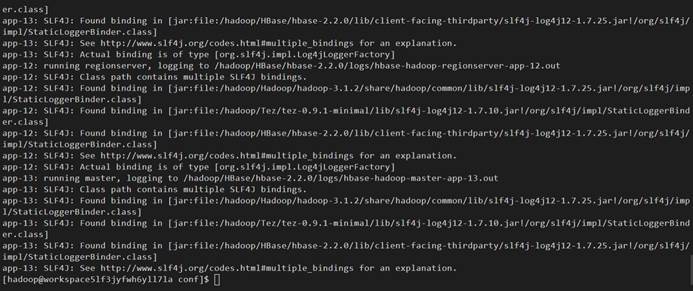

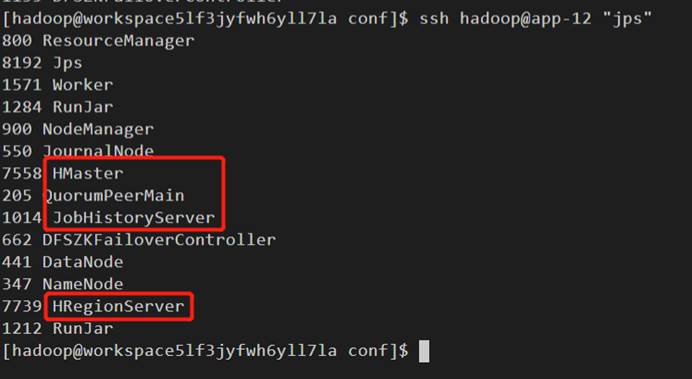

20、在app-12上启动HBase,因为app-12是HBASE_MASTER

命令:```ssh hadoop@app-12 "cd /hadoop/HBase/hbase-2.2.0/bin && ./start-hbase.sh"```

21、查看是否启动成功

命令:```ssh hadoop@app-12 "jps"```

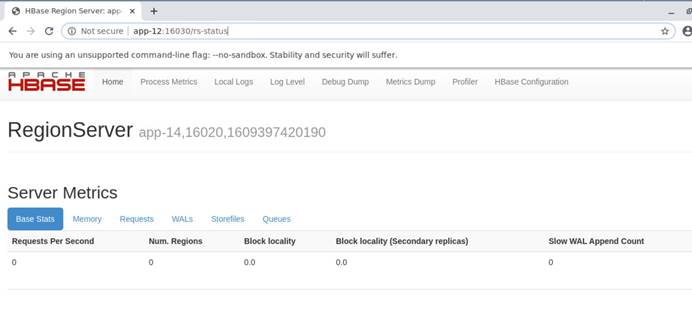

22、打开HBaseWeb监控页面

网址:http:// app-12:16030

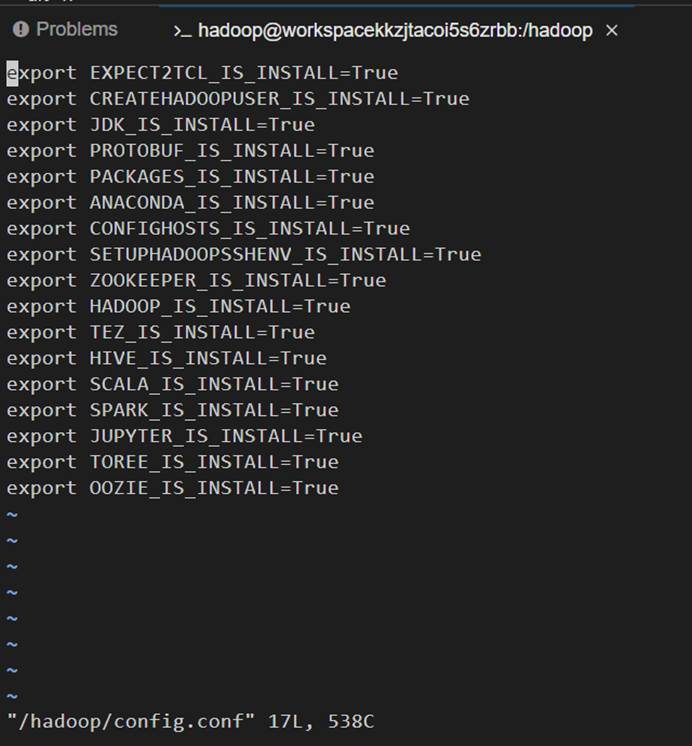

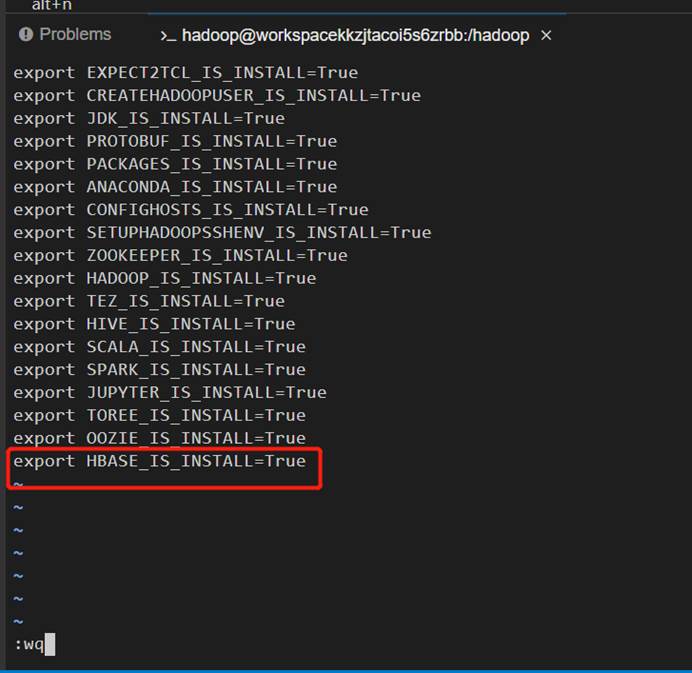

## 设置自动化脚本

23、添加到自动启动中

命令:```vi /hadoop/config.conf```

24、添加export HBASE_IS_INSTALL=True

25、使环境变量生效

命令:```source ~/.bashrc```

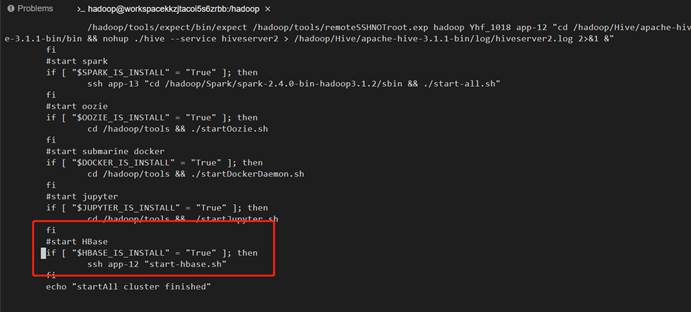

26、确认start.all脚本有HBase

命令:```vi /hadoop/startAll.sh```

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰