关于课程环境

- 这里的大数据集群的配置和企业生产环境保持一致,如HA(高可用)、核心功能组件、主要服务(daemon);与之相对应的是需要消耗一定量的内存。

- 大数据环境说明如下,其中后面的集群均会包含前面的组件,如Hive集群会包含Hive、Tez、Hadoop、ZooKeeper、SSHEnv:

Centos7C1/C2/C3: 三台裸服务器。

SSHEnvC1/C2/C3: 配置root用户和hadoop用户ssh免密登录。

ZooKeeperC1/C2/C3: 搭建了ZooKeeper集群。

HadoopC1/C2/C3: 搭建了Hadoop集群。

TezC2/C2/C3: 搭建了带Tez的Hadoop集群。

HiveC1/C2/C3: 搭建了Hive集群。

SparkC1/C2/C3: 搭建了Spark集群。

OozieC1/C2/C3: 搭建了Oozie集群。

HBaseC1/C2/C3: 搭建了HBase集群。

KafkaC1/C2/C3: 搭建了Kafka集群。

RedisC1/C2/C3: 搭建了Redis集群。

FlumeSqoopC1/C2/C3: 搭建了Flume/Sqoop集群。

ElasticsearchC1/C2/C3: 搭建了Elasticsearch集群。

FlinkC1/C2/C3: 搭建了Flink集群。

HudiC1/C2/C3: 搭建了Hudi集群。

SolrC1/C2/C3: 搭建了Solr集群。

AtlasC1/C2/C3: 搭建了Atlas集群。

BigDataWithLoadedDataC1/C2/C3: 集成了除Solr/Atlas组件之外的集群、并加载了相应的数据集,具体数据集参考应用案例。

-

同一个角色(C1、C2、C3)的服务器只能创建一个,如HadoopC1和ZooKeeperC1不能同时创建成功,但HadoopC1和ZooKeeperC2能同时创建成功、尽管这么做没有意义。

-

数据可视化环境参考"数据可视化分析"章节说明。

She平台高校版学生端网络设置

学生通过PC个人电脑的Chrome浏览器登录She平台高校版、具体网址由授课老师发布(但肯定不同于She平台C端版地址:http://she.kinginsai.com)。

She平台高校版通常部署在相应学校的机房环境中,学生PC个人电脑需要同时具备访问外网和访问学校机房环境的网络接入条件。

She平台高校版的资源

-

本课程的字母名称为"BigData",其中(http)文件服务器上的根目录名称"BigData"、gitlab服务器的仓库名称为"BigData"、松鼠学苑GitHub仓库的名称为"Spark-stack"。

-

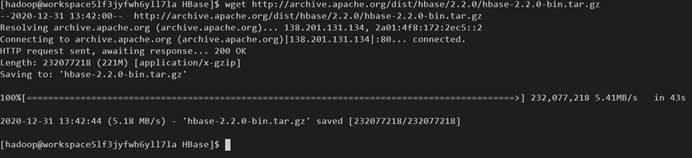

She平台C端版(http://she.kinginsai.com)的服务端有外网权限,所以松鼠学苑的标准课程均从资源的源端下载、如https://archive.apache.org/dist/hadoop/common/hadoop-3.1.2/hadoop-3.1.2.tar.gz;但通常She平台高校版的服务端没有外网权限(这个很容测试、如ping www.baidu.com),因此需要通过(http)文件服务器/gitlab服务器下载、或者从学生本地计算机上传的方式解决。

-

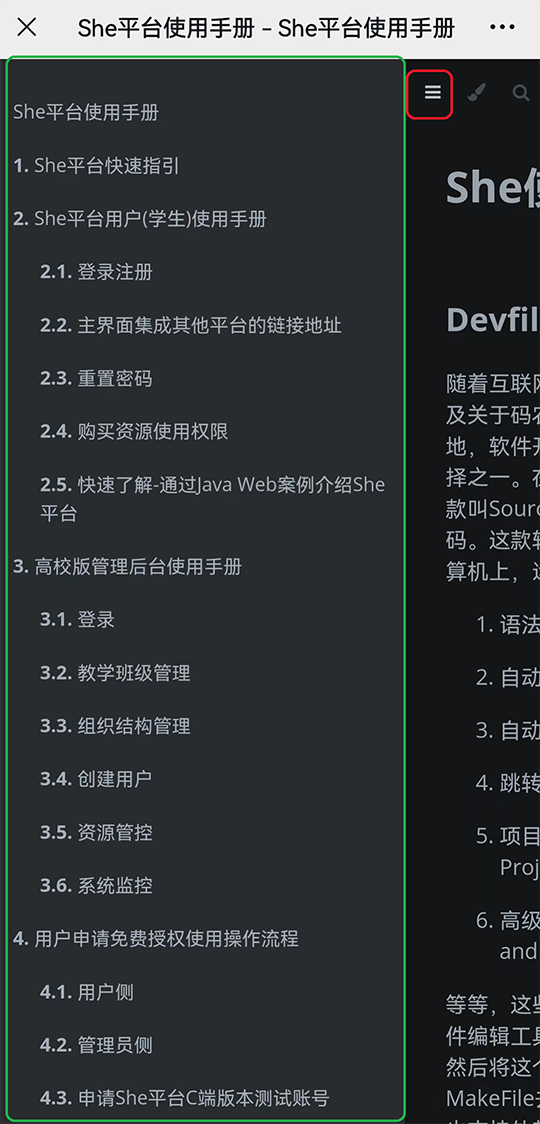

文件资源放在(http)文件服务器上,可以阅读She平台手册的"She平台课程环境详细操作说明"部分,这样在学生可使用wget命令下载到实训环境中,因为文件服务器和She平台是部署在同一内网中;如果对应高校版本中没有部署(http)文件服务器、或者(http)文件服务器中没有相应资源,可以在学生个人电脑端从互联网下载相应资源到本地,然后上传到实训环境中,具体方法参考She平台手册的"ssh远程连接远端服务器工具"部分。

-

配置文件、代码等教学资源放在gitlab服务器上,可以阅读She平台手册的"She平台课程环境详细操作说明"部分,这样在学生可使用git clone命令下载到实训环境中,因为gitlab服务器和She平台是部署在同一内网中;如果对应高校版本中没有部署gitlab服务器、或者gitlab服务器中没有相应资源,可以在学生个人电脑端从松鼠学苑的github仓库(https://github.com/haiye1018/)下载相应资源到本地,压缩后上传到实训环境中,具体方法参考She平台手册的"ssh远程连接远端服务器工具"部分。

什么是大数据

1、是基础设施。

2、是方法论。

课程体系

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

关于课程环境

- 这里的大数据集群的配置和企业生产环境保持一致,如HA(高可用)、核心功能组件、主要服务(daemon);与之相对应的是需要消耗一定量的内存。

- 大数据环境说明如下,其中后面的集群均会包含前面的组件,如Hive集群会包含Hive、Tez、Hadoop、ZooKeeper、SSHEnv:

Centos7C1/C2/C3: 三台裸服务器。

SSHEnvC1/C2/C3: 配置root用户和hadoop用户ssh免密登录。

ZooKeeperC1/C2/C3: 搭建了ZooKeeper集群。

HadoopC1/C2/C3: 搭建了Hadoop集群。

TezC2/C2/C3: 搭建了带Tez的Hadoop集群。

HiveC1/C2/C3: 搭建了Hive集群。

SparkC1/C2/C3: 搭建了Spark集群。

OozieC1/C2/C3: 搭建了Oozie集群。

HBaseC1/C2/C3: 搭建了HBase集群。

KafkaC1/C2/C3: 搭建了Kafka集群。

RedisC1/C2/C3: 搭建了Redis集群。

FlumeSqoopC1/C2/C3: 搭建了Flume/Sqoop集群。

ElasticsearchC1/C2/C3: 搭建了Elasticsearch集群。

FlinkC1/C2/C3: 搭建了Flink集群。

HudiC1/C2/C3: 搭建了Hudi集群。

SolrC1/C2/C3: 搭建了Solr集群。

AtlasC1/C2/C3: 搭建了Atlas集群。

BigDataWithLoadedDataC1/C2/C3: 集成了除Solr/Atlas组件之外的集群、并加载了相应的数据集,具体数据集参考应用案例。

-

同一个角色(C1、C2、C3)的服务器只能创建一个,如HadoopC1和ZooKeeperC1不能同时创建成功,但HadoopC1和ZooKeeperC2能同时创建成功、尽管这么做没有意义。

-

数据可视化环境参考"数据可视化分析"章节说明。

She平台高校版学生端网络设置

学生通过PC个人电脑的Chrome浏览器登录She平台高校版、具体网址由授课老师发布(但肯定不同于She平台C端版地址:http://she.kinginsai.com)。

She平台高校版通常部署在相应学校的机房环境中,学生PC个人电脑需要同时具备访问外网和访问学校机房环境的网络接入条件。

She平台高校版的资源

-

本课程的字母名称为"BigData",其中(http)文件服务器上的根目录名称"BigData"、gitlab服务器的仓库名称为"BigData"、松鼠学苑GitHub仓库的名称为"Spark-stack"。

-

She平台C端版(http://she.kinginsai.com)的服务端有外网权限,所以松鼠学苑的标准课程均从资源的源端下载、如https://archive.apache.org/dist/hadoop/common/hadoop-3.1.2/hadoop-3.1.2.tar.gz;但通常She平台高校版的服务端没有外网权限(这个很容测试、如ping www.baidu.com),因此需要通过(http)文件服务器/gitlab服务器下载、或者从学生本地计算机上传的方式解决。

-

文件资源放在(http)文件服务器上,可以阅读She平台手册的"She平台课程环境详细操作说明"部分,这样在学生可使用wget命令下载到实训环境中,因为文件服务器和She平台是部署在同一内网中;如果对应高校版本中没有部署(http)文件服务器、或者(http)文件服务器中没有相应资源,可以在学生个人电脑端从互联网下载相应资源到本地,然后上传到实训环境中,具体方法参考She平台手册的"ssh远程连接远端服务器工具"部分。

-

配置文件、代码等教学资源放在gitlab服务器上,可以阅读She平台手册的"She平台课程环境详细操作说明"部分,这样在学生可使用git clone命令下载到实训环境中,因为gitlab服务器和She平台是部署在同一内网中;如果对应高校版本中没有部署gitlab服务器、或者gitlab服务器中没有相应资源,可以在学生个人电脑端从松鼠学苑的github仓库(https://github.com/haiye1018/)下载相应资源到本地,压缩后上传到实训环境中,具体方法参考She平台手册的"ssh远程连接远端服务器工具"部分。

什么是大数据

1、是基础设施。

2、是方法论。

课程体系

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

关于课程环境

- 这里的大数据集群的配置和企业生产环境保持一致,如HA(高可用)、核心功能组件、主要服务(daemon);与之相对应的是需要消耗一定量的内存。

- 大数据环境说明如下,其中后面的集群均会包含前面的组件,如Hive集群会包含Hive、Tez、Hadoop、ZooKeeper、SSHEnv:

Centos7C1/C2/C3: 三台裸服务器。

SSHEnvC1/C2/C3: 配置root用户和hadoop用户ssh免密登录。

ZooKeeperC1/C2/C3: 搭建了ZooKeeper集群。

HadoopC1/C2/C3: 搭建了Hadoop集群。

TezC2/C2/C3: 搭建了带Tez的Hadoop集群。

HiveC1/C2/C3: 搭建了Hive集群。

SparkC1/C2/C3: 搭建了Spark集群。

OozieC1/C2/C3: 搭建了Oozie集群。

HBaseC1/C2/C3: 搭建了HBase集群。

KafkaC1/C2/C3: 搭建了Kafka集群。

RedisC1/C2/C3: 搭建了Redis集群。

FlumeSqoopC1/C2/C3: 搭建了Flume/Sqoop集群。

ElasticsearchC1/C2/C3: 搭建了Elasticsearch集群。

FlinkC1/C2/C3: 搭建了Flink集群。

HudiC1/C2/C3: 搭建了Hudi集群。

SolrC1/C2/C3: 搭建了Solr集群。

AtlasC1/C2/C3: 搭建了Atlas集群。

BigDataWithLoadedDataC1/C2/C3: 集成了除Solr/Atlas组件之外的集群、并加载了相应的数据集,具体数据集参考应用案例。

-

同一个角色(C1、C2、C3)的服务器只能创建一个,如HadoopC1和ZooKeeperC1不能同时创建成功,但HadoopC1和ZooKeeperC2能同时创建成功、尽管这么做没有意义。

-

数据可视化环境参考"数据可视化分析"章节说明。

She平台高校版学生端网络设置

学生通过PC个人电脑的Chrome浏览器登录She平台高校版、具体网址由授课老师发布(但肯定不同于She平台C端版地址:http://she.kinginsai.com)。

She平台高校版通常部署在相应学校的机房环境中,学生PC个人电脑需要同时具备访问外网和访问学校机房环境的网络接入条件。

She平台高校版的资源

-

本课程的字母名称为"BigData",其中(http)文件服务器上的根目录名称"BigData"、gitlab服务器的仓库名称为"BigData"、松鼠学苑GitHub仓库的名称为"Spark-stack"。

-

She平台C端版(http://she.kinginsai.com)的服务端有外网权限,所以松鼠学苑的标准课程均从资源的源端下载、如https://archive.apache.org/dist/hadoop/common/hadoop-3.1.2/hadoop-3.1.2.tar.gz;但通常She平台高校版的服务端没有外网权限(这个很容测试、如ping www.baidu.com),因此需要通过(http)文件服务器/gitlab服务器下载、或者从学生本地计算机上传的方式解决。

-

文件资源放在(http)文件服务器上,可以阅读She平台手册的"She平台课程环境详细操作说明"部分,这样在学生可使用wget命令下载到实训环境中,因为文件服务器和She平台是部署在同一内网中;如果对应高校版本中没有部署(http)文件服务器、或者(http)文件服务器中没有相应资源,可以在学生个人电脑端从互联网下载相应资源到本地,然后上传到实训环境中,具体方法参考She平台手册的"ssh远程连接远端服务器工具"部分。

-

配置文件、代码等教学资源放在gitlab服务器上,可以阅读She平台手册的"She平台课程环境详细操作说明"部分,这样在学生可使用git clone命令下载到实训环境中,因为gitlab服务器和She平台是部署在同一内网中;如果对应高校版本中没有部署gitlab服务器、或者gitlab服务器中没有相应资源,可以在学生个人电脑端从松鼠学苑的github仓库(https://github.com/haiye1018/)下载相应资源到本地,压缩后上传到实训环境中,具体方法参考She平台手册的"ssh远程连接远端服务器工具"部分。

什么是大数据

1、是基础设施。

2、是方法论。

课程体系

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

创建并初始化环境

以下步骤是其它章节必须的步骤,只需要做一次即可,不能多次初始化。

1、创建参考对应章节。

"HadoopC1/C2/C3: 搭建了Hadoop集群"是可以做Hadoop应用的集群,而想搭建Hadoop集群则需要创建"ZooKeeperC1/C2/C3: 搭建了ZooKeeper集群"、并在此基础上开展搭建工作;当完全掌握搭建之后想学习Hadoop应用层面的知识,可直接创建"HadoopC1/C2/C3: 搭建了Hadoop集群"并在此集群上完成后续的实验操作。

其他阶段的集群遵循上述原理。

2、New terminal.

3、切换到root用户。 命令:

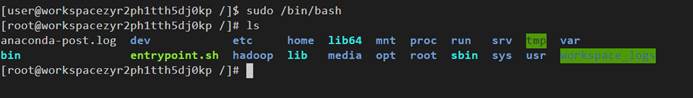

sudo /bin/bash

为什么使用上面的命令而不是用'su - root'呢?因为'sudo /bin/bash'不需要输入密码,而'su - root'需要;但它们的效果是等价的。

4、进入hadoop目录。 命令:

cd /hadoop/

5、运行initHost.sh脚本,配置本机ip和名称(app-11)对应关系。 命令:

./initHosts.sh

6、切换到hadoop用户下,进入hadoop根目录。 命令:

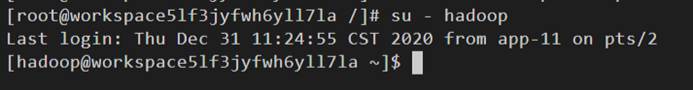

su - hadoop

cd /hadoop/

7、启动环境。 命令:

./startAll.sh

保证当前shell的用户为hadoop(如果当前用户已经是hadoop,此步可忽略)

1、切换到root用户。 命令:

sudo /bin/bash

为什么使用上面的命令而不是用'su - root'呢?因为'sudo /bin/bash'不需要输入密码,而'su - root'需要;但它们的效果是等价的。

2、切换到hadoop用户下。 命令:

su - hadoop

什么是分布式协同

以电商平台为例,在电商平台初期是单应用架构,所谓但应用架构是将应用部分和数据部分放在同一台服务器上,对外提供服务。 但是随着业务的发展 我们的并发量成爆炸式的发展,为了应对这种爆发式的增长,需要将应用和数据进行拆分,应用拆分就是将应用部分拆分成多个子系统,并且每一个子系统,每一个功能部署多个服务,那么,如何协调多个相同功能,这就是协同工作的出发点。数据库拆分提高读取的效率。

为什么选择zookeeper

zookeeper的应用性能和性能非常的好,ZooKeeper的设计保证了其健壮性,这就使得应用开发人员可以更多关注应用本身的逻辑,而不是协同工作上。ZooKeeper从文件系统API得到启发,提供一组简单的API,使得开发人员可以实现通用的协作任务,包括选举主节点、管理组内成员关系、管理元数据等。ZooKeeper包括一个应用开发库(主要提供Java和C两种语言的API)和一个用Java实现的服务组件。ZooKeeper的服务组件运行在一组专用服务器之上,保证了高容错性和可扩展性。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

什么是分布式协同

以电商平台为例,在电商平台初期是单应用架构,所谓但应用架构是将应用部分和数据部分放在同一台服务器上,对外提供服务。 但是随着业务的发展 我们的并发量成爆炸式的发展,为了应对这种爆发式的增长,需要将应用和数据进行拆分,应用拆分就是将应用部分拆分成多个子系统,并且每一个子系统,每一个功能部署多个服务,那么,如何协调多个相同功能,这就是协同工作的出发点。数据库拆分提高读取的效率。

为什么选择zookeeper

zookeeper的应用性能和性能非常的好,ZooKeeper的设计保证了其健壮性,这就使得应用开发人员可以更多关注应用本身的逻辑,而不是协同工作上。ZooKeeper从文件系统API得到启发,提供一组简单的API,使得开发人员可以实现通用的协作任务,包括选举主节点、管理组内成员关系、管理元数据等。ZooKeeper包括一个应用开发库(主要提供Java和C两种语言的API)和一个用Java实现的服务组件。ZooKeeper的服务组件运行在一组专用服务器之上,保证了高容错性和可扩展性。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

准备工作

1、第一步分别建立SSHEnvC1、2、3

正常运行

2、在SSHEvnC1中操作,New terminal

2、在SSHEvnC1中操作,New terminal

3、切换到root用户。

命令:sudo /bin/bash

4、进入hadoop目录下并查看有哪些文件夹。

命令:cd /hadoop/

5、运行initHost.sh脚本,进行三台机器的认证:./initHosts.sh 。

命令:./initHosts.sh

运行效果:

安装zookeeper安装包

1、 在app11中操作,切换到hadoop用户,密码Yhf_1018

命令:su – hadoop注:输入的密码是不显示出来的。

2、 进入hadoop根目录,并查看目录下的文件。

命令:cd /hadoop/

3、创建一个ZooKeeper安装的根目录。

命令:mkdir ZooKeeper

4、 进入到ZooKeeper目录下。

命令:cd ZooKeeper/

5、上传安装包我们这里用的版本是zookeeper-3.4.10,通过wget命令在网上直接上传,wget+网址。

命令:wget http://archive.apache.org/dist/zookeeper/zookeeper-3.4.10/zookeeper-3.4.10.tar.gz

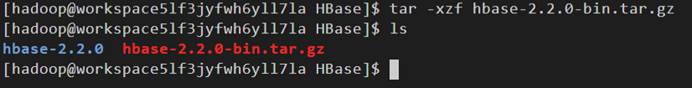

6、 安装包解压,会出现一个zookeeper-3.4.10 的文件夹。

命令:tar -xf zookeeper-3.4.10.tar.gz

7、进入zookeeper-3.4.10文件夹,文件中有一个conf文件。

命令:cd zookeeper-3.4.10

8、 进入conf文件夹,文件中有一个zoo_sample.cfg文件,将zoo_sample.cfg文件改名为zoo.cfg。

命令:mv zoo_sample.cfg zoo.cfg注:文件名之间要有空格。

9、 查看zoo.cfg内容。

命令:vi zoo.cfg

运行效果:

运行效果:

10、将原文件的dataDir改为/hadoop/ZooKeeper/zookeeper-3.4.10/data,注:按i进行内容更改,先按ESC再输入:wq进行文件保存并退出。

11、设置集群的server,再刚才的zoo.cfg文件中继续操作,再文件的最后内容中加入

server.1=app-11:2888:3888

server.2=app-12:2888:3888

server.3=app-13:2888:3888

并保存退出。

12、进入上一层目录,目录为zookeeper-3.4.10,该目录下不存在data目录,需要创建data目录和myid文件,myid对应的id为conf的id,打开myid文件。

命令:mkdir data、touch data/myid、vi data/myid

运行效果:

运行效果:

13、输入1,这是myid的内容,并保存退出。

14、返回根目录。

命令:cd ..

设置环境变量

1、命令:vi ~/.bashrc

运行效果:

2、设置ZOOKEEPER_HOME目录和PATH目录,在环境变量中加入

export ZOOKEEPER_HOME=/hadoop/ZooKeeper/zookeeper-3.4.10

export PATH=${ZOOKEEPER_HOME}/bin:$PATH

保存并退出。

3、当前的PATH中并没有ZOOKEEPER目录,需要使用source命令让刚刚的修改过的PATH执行。

命令:echo $PATH、source ~/.bashrc

其他集群设置

1、 首先免密登录到app-12上,进入hadoop目录下创建ZooKeeper文件。

命令:ssh hadoop@app-12 "cd /hadoop && mkdir ZooKeeper"

2、所有的集群目录都是一样,需要将整个zookeeper安装包拷贝到其他集群的机器上。

命令:scp -r zookeeper-3.4.10 hadoop@app-12:/hadoop/ZooKeeper注:-r是表示拷贝整个目录。

运行效果:

运行效果:

3、需要将app-12的myid改为2。

登录app-12。

命令:ssh hadoop@app-12

4、进入ZooKeeper目录下,有zookeeper-3.4.10证明刚才的拷贝完成。

命令:cd /hadoop/ZooKeeper/

5、 进入到zookeeper-3.4.10/data目录下,打开myid文件。

命令:cd zookeeper-3.4.10/、cd data/、vi myid

运行效果:

运行效果:

6、 将1改为2,并保存退出。

7、退出app-12。

命令:exit

8、将环境变量拷贝到app-12上,进行覆盖拷贝。

命令:

8、将环境变量拷贝到app-12上,进行覆盖拷贝。

命令:scp ~/.bashrc hadoop@app-12:~/

app-12完成。同理,在app-13上执行。

9、在app-13上创建目录,并拷贝文件,这里使用的是静默拷贝。

命令:ssh hadoop@app-13 "cd /hadoop && mkdir ZooKeeper"

scp -r -p zookeeper-3.4.10

hadoop@app-13:/hadoop/ZooKeeper/

10、拷贝环境变量。

命令:scp ~/.bashrc hadoop@app-13:~/

11、登录到app-13上修改myid文件。

命令:ssh hadoop@app-13

vi /hadoop/ZooKeeper/zookeeper-3.4.10/data/myid

运行效果:

运行效果:

12、将1修改为3,并保存退出。

13、退出app-13。

检验是否成功

分别登录app-11、app-12、app-13,执行命令:zkServer.sh start,成功运行出效果图,证明成功。

常见问题

问题:zkServer.sh start无法正常运行。

解决办法:检查zookeeper的环境变量是否正确。

问题:zkServer.sh start无法正常运行。

解决办法:检查zookeeper的环境变量是否正确。

含义是:免密登录APP-13并在app-13用户中进行zkServer.sh status操作。

hadoop@app-13和“zkServer.sh status”之间一定要有空格。

含义是:免密登录APP-13并在app-13用户中进行zkServer.sh status操作。

hadoop@app-13和“zkServer.sh status”之间一定要有空格。

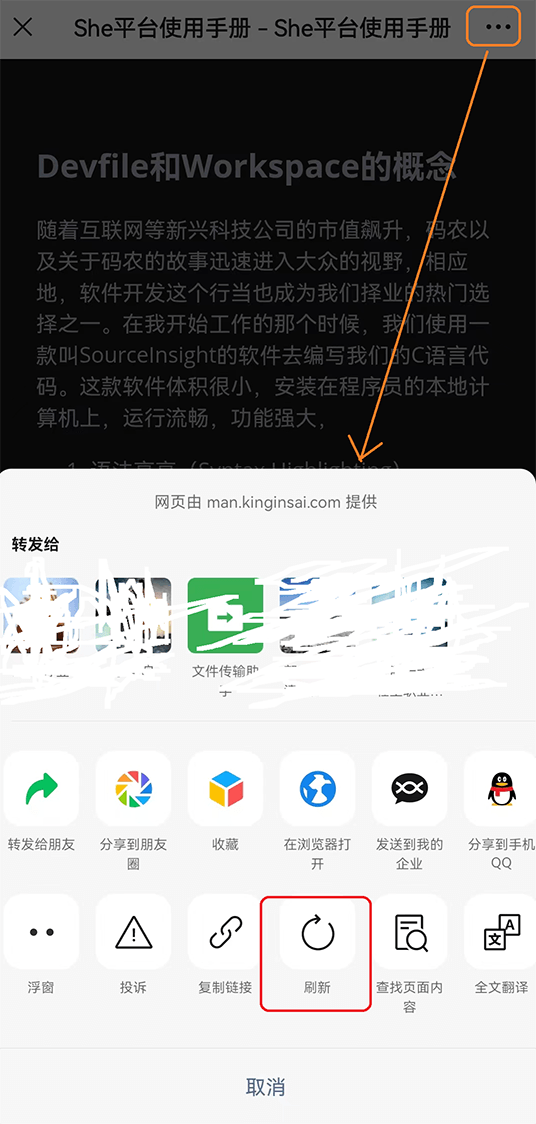

问题:可能网络不稳定,缺少某个插件。

解决办法:重新刷新。

问题:可能网络不稳定,缺少某个插件。

解决办法:重新刷新。

问题:运行失败。

解决办法:重新刷新运行。

问题:运行失败。

解决办法:重新刷新运行。

问题:该错误为当前用户没有权限对文件作修改。

解决办法:按ESC在输入:q!退出即可。

问题:该错误为当前用户没有权限对文件作修改。

解决办法:按ESC在输入:q!退出即可。

问题:在执行zkServer.sh start时出现的弹框。

解决办法:直接点x就可以。

问题:在执行zkServer.sh start时出现的弹框。

解决办法:直接点x就可以。

问题:网络出现波动。

解决办法:多几次刷新页面,重新进入Workspace或者重新登录she平台。

问题:网络出现波动。

解决办法:多几次刷新页面,重新进入Workspace或者重新登录she平台。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

zookeeper客户端基本操作

1、首先切换到hadoop用户下。

命令:su - hadoop

2、确保zookeeper集群的正常启动的。

命令:zkServer.sh status

这里的app-11是follower.

这里的app-11是follower.

3、分别查看app-12、app-13谁是lead.

命令:ssh hadoop@app-12 "zkServer.sh status"、ssh hadoop@app-13 "zkServer.sh status"

4、运行客户端。

命令:zkCli.sh

5、看下客户端有什么命令。

命令:help

6、查看根目录下有什么。

命令:ls /

7、创建一个test并在test目录下存放数据zk。

命令:create /test "zk"

8、在查看根目录下。

命令:ls /

9、取出test中的数据。

命令:get /test

10、删除test目录.。

命令:delete /test

11、创建临时节点。

命令:create -e /test "lock"

12、模拟异常退出,按Ctrl+C,等待30秒。

13、重新登录到客户端。

命令:zkCli.sh

14、查看根目录。

命令:ls /

临时节点消失。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

zookeeper分布式锁是干什么的

zookeeper实现分布式锁的原理就是多个节点同时在一个指定的节点下面创建临时会话顺序节点,谁创建的节点序号最小,谁就获得了锁,并且其他节点就会监听序号比自己小的节点,一旦序号比自己小的节点被删除了,其他节点就会得到相应的事件,然后查看自己是否为序号最小的节点,如果是,则获取锁。

为什么使用zookeeper分布式锁?

使用分布式锁的目的,无外乎就是保证同一时间只有一个客户端可以对共享资源进行操作。 但是Martin指出,根据锁的用途还可以细分为以下两类: (1)允许多个客户端操作共享资源 这种情况下,对共享资源的操作一定是幂等性操作,无论你操作多少次都不会出现不同结果。在这里使用锁,无外乎就是为了避免重复操作共享资源从而提高效率。 (2)只允许一个客户端操作共享资源 这种情况下,对共享资源的操作一般是非幂等性操作。在这种情况下,如果出现多个客户端操作共享资源,就可能意味着数据不一致,数据丢失。

分布式锁操作

1、 在app-11上创建一个临时节点并存入数据lock。

命令:create -e /test "lock"

2、在app-12上登录到hadoop用户下,并切换到客户端。

命令:su – hadoop、zkCli.sh

3、 创建一个和app-11一样的临时节点,路径也相同。

命令:create -e /test "lock"

这里说明创建失败。

这里说明创建失败。

4、 在app-12上创建一个通知,监视test。

命令:stat /test true

5、 在app-11上删除test节点。

命令:delete /test

6、返回app-12。

7、 此处的监视是一次性,还想监视,需要在输入一次命令。

命令:stat /test true

这里显示说明,这个test不存在。

这里显示说明,这个test不存在。

8、在app-11上再创建一次test。

命令:create -e /test "lock"

9、返回app-12上。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

ZooKeeper主从应用

原理

1、zookeeper能做什么? 它可以在分布式系统中协作多个任务,一个协作任务是指一个包含多个进程的任务

2、真实系统中的三个问题 1.消息延迟 2.处理器性能 3.时钟偏移

3、主从模式的三个问题 1.主节点崩溃 :如果主节点发送错误并失效,系统将无法分配新的任务或重新分配已失败的任务。2.从节点崩溃:如果从节点崩溃,已分配的任务将无法完成。 3.通信故障:如果主节点和从节点之间无法进行信息交换,从节点将无法得知新任务分配给它。

4、主-从架构的需求 主节点选举:这是关键的一步,使得主节点可以给从节点分配任务 崩溃检测:主节点必须具有检测从节点崩溃或失去连接的能力。 组成员关系管理:主节点必须具有知道哪一个从节点可以执行任务的能力。 元数据管理:主节点和从节点必须具有通过某种可靠的方式来保存分配状态和执行状态的能力。

5、 监视与通知

操作

app-11为主节点,app-12为从节点、app-13为客户端。

1、 分别用app-11、app-12、app-13登录到客户端。

命令:su – hadoop、zkCli.sh

2、 在主节点上创建一个临时节点并存入数据app-11。

命令:create -e /master "app-11"

3、分别创建临时节点workers、tasks、assign。

命令:create /workers ""、create /tasks ""、create /assign ""

4、使用ls多项监控。

命令:ls /workers true、ls /tasks true

5、在从节点上向workers注册一个节点,并存入自己的节点信息。

命令:creat -e workers/worker1 "app-12"

6、 返回到app-11上。

7、 在客户端上,创建有序的任务。

命令:create -s /tasks/task- "cmd"

8、 返回主节点。

9、在主节点上创建任务节点worker1。

命令:create /assign/worker1 ""

10、在从节点上监控任务节点,因为任务节点还没有创建,所以用stat命令。

命令:stat /assign/worker1/task-0000000000 true

11、在主节点上创建任务节点。

命令:create /assign/worker1/task-0000000000 ""

12、返回从节点.

13、同理在主节点上监控任务完成的状况。

命令:stat /assign/worker1/task-0000000000/status true

14、在从节点上创建任务完成状态,假设ok。

命令:create /assign/worker1/task-0000000000/status "OK"

15、返回主节点。

ZooKeeper清理工作

1、 登录hadoop用户。

命令:su – Hadoop

2、 登录到客户端。

命令:zkCli.sh

3、 删除其他节点,先查看有哪些节点。

命令:ls /

4、删除其他多余节点,只留zookeeper节点。

命令:rmr /workers、rmr /test、rmr /tasks、rmr /master、rmr /assign

5、 退出。

命令:quit

常见问题

问题原因:临时节点下不能创建子节点

解决办法:检查workers是否为临时节点,删除workers重新创建。

问题原因:临时节点下不能创建子节点

解决办法:检查workers是否为临时节点,删除workers重新创建。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

为什么引入大数据

hadoop概述

基本集群环境搭建

学习hadoop3首先不是学习hadoop的概念,因为hadoop是比较复杂的模块,是大数据基础的环境,我们把整个环境搭建好了之后,可以边操作边理解hadoop的功能,比如说MapReduce、YARN、HDFS。而且在基本环境之上,再进行改造,加入每一节课讲解的新内容。这样可以更早的接触到Hadoop集群,能够快速的理解。

逻辑的集群,包括了两个NN、两个RM、三个JN节点、三个DN节点,对应的物理部署形式是包括了app-11、app-12和app-13。在app-11上部署了NN1和RM1,在app-12上部署了NN2和RM2,三个DN和三个JN分别部署在app-11、app-12和app-13,因为整个系统只有三个机器,其中app-11和app-12分别分配了4G内存,app-13只有2g内存,所以app-13的任务会稍微减轻一点。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

为什么引入大数据

hadoop概述

基本集群环境搭建

学习hadoop3首先不是学习hadoop的概念,因为hadoop是比较复杂的模块,是大数据基础的环境,我们把整个环境搭建好了之后,可以边操作边理解hadoop的功能,比如说MapReduce、YARN、HDFS。而且在基本环境之上,再进行改造,加入每一节课讲解的新内容。这样可以更早的接触到Hadoop集群,能够快速的理解。

逻辑的集群,包括了两个NN、两个RM、三个JN节点、三个DN节点,对应的物理部署形式是包括了app-11、app-12和app-13。在app-11上部署了NN1和RM1,在app-12上部署了NN2和RM2,三个DN和三个JN分别部署在app-11、app-12和app-13,因为整个系统只有三个机器,其中app-11和app-12分别分配了4G内存,app-13只有2g内存,所以app-13的任务会稍微减轻一点。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Hadoop高可用集群搭建过程视频

Hadoop高可用集群搭建验证视频

前期准备工作

1、第一步分别建立ZookeeperC1、2、3。

2、在app11中操作,New terminal.

注意:下面的命令当中可能有格式错误,需要同学根据对步骤的理解修正。

3、切换到root用户。

命令:sudo /bin/bash

4、进入hadoop目录下并查看有哪些文件夹。

命令:cd /hadoop/ 、ls

5、运行initHost.sh脚本,进行三台机器的认证。

命令:./initHosts.sh 。

运行效果:

6、切换到hadoop用户下,进入hadoop根目录。

命令:su - hadoop、cd /hadoop/

7、启动zookeeper集群。

命令:./startAll.sh

以上步骤是启动任一阶段集群的全部过程,如启动hadoop阶段的集群、Spark阶段的集群。

hadoop环境搭建

安装hadoop安装包

1、在app-11上,切换到hadoop用户。

命令:su - hadoop

注:输入的密码是不显示出来的。

2、进入hadoop根目录,并查看目录下的文件。

命令:cd /hadoop/

3、创建一个安装Hadoop的根目录。

命令:mkdir Hadoop

4、进入到Hadoop目录下。

命令:cd Hadoop/

5、下载hadoop安装包。

命令:wget https://archive.apache.org/dist/hadoop/common/hadoop-3.1.2/hadoop-3.1.2.tar.gz

6、解压安装包。

命令:tar -xf hadoop-3.1.2.tar.gz

7、进入到/tmp目录下。

命令:cd /tmp/

8、通过GitHub下载Spark-stack。

命令:git clone https://github.com/haiye1018/Spark-stack

9、进入Spark-stack/目录下。

命令:cd Spark-stack/

10、 进入Hadoop目录下。

命令:cd Hadoop/

11、 将conf拷贝到hadoop-3.1.2/etc/hadoop目录下,并查看是否成功。

命令:cp conf/* /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/、cat /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/workers

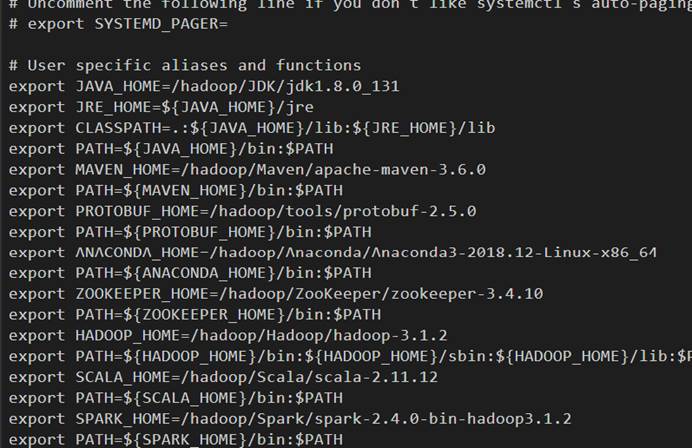

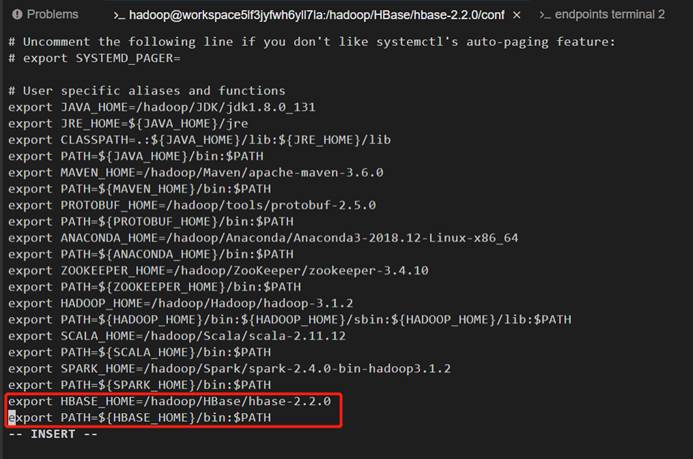

12、在环境变量中加入hadoop和HADOOP_HOME路径。

命令:vi ~/.bashrc、

export HADOOP_HOME=/hadoop/Hadoop/hadoop-3.1.2

exporPATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:${HADOOP_HOME}/lib:$PATH

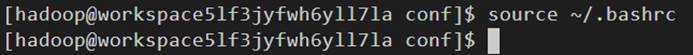

13、将设置的环境变量生效。

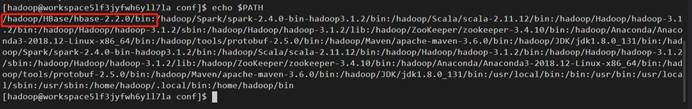

命令:source ~/.bashrc、echo $PATH

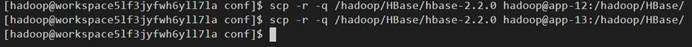

将hadoop安装包拷贝集群中的另两台机器上

14、先创建安装的根目录。

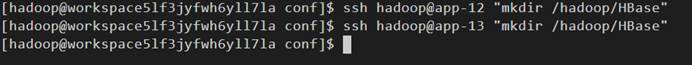

命令:ssh hadoop@app-12 "mkdir /hadoop/Hadoop"、sshhadoop@app-13 "mkdir /hadoop/Hadoop"

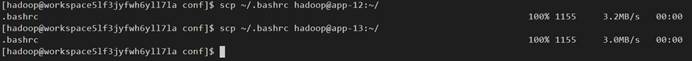

15、将环境变量拷贝到集群的另外两个机器上。

命令:scp ~/.bashrc hadoop@app-12:~/、scp ~/.bashrchadoop@app-13:~/

16、 将改好的安装包拷贝到集群的另外两个机器上。

命令:cd /hadoop/Hadoop、scp -r -q hadoop-3.1.2 hadoop@app-12:/hadoop/Hadoop、scp -r -q hadoop-3.1.2 hadoop@app-13:/hadoop/Hadoop

hadoop初始化工作

17、 需要将所有的journalnode守护进程启动,接下来是用一个循环脚本启动。

命令:for name in app-11 app-12 app-13; do ssh hadoop@$name"hdfs --daemon start journalnode"; done

18、 查看journalnode是否启动。

命令:for name in app-11 app-12app-13; do ssh hadoop@$name "jps"; done注:显示的是三个journalnode守护进程,三个zookeeper守护进程。

19、 在app-11namenode上各式化。

命令:hdfs namenode -format注:会打印很多classpath

20、 因为是两台namenode做ha,需要在另一台机器上拷贝格式化信息,先关闭所有守护进程。

命令:for name in app-11 app-12 app-13; do ssh hadoop@$name "hdfs--daemon stop journalnode"; done

创建ha节点

21、创建ha主从应用里zookeeper目录树的目录,先登录到客户端查看ha存不存在。

命令:zkCli.sh

22、 查看客户端下有什么。

命令:ls /

23、 只有一个zookeeper节点,ha节点并不存在,退出。

命令:quit

24、 zookeeper初始化工作。

命令:

24、 zookeeper初始化工作。

命令:hdfs zkfc -formatZK -force注:打印很多的classpath

25、 再次登录到客户端,查看ha节点存不存在。

命令:zkCli.sh

26、 查看根目录下有什么。

命令:ls /注:这时候有一个hadoop-ha节点

27、 查看hadoop-ha节点下。

命令:ls /hadoop-ha

28、 查看dmcluster节点下,dmcluster节点下是空的,dmcluster是ha下的集群。

命令:ls /hadoop-ha/dmcluster

29、 证明ha节点存在之后,退出。

命令:quit

将app-11namenode的初始化信息同步到app-12上

30、 先启动dfs整个的系统。

命令:start-dfs.sh

31、 免密登录到app-12上执行。

命令:ssh hadoop@app-12 "hdfsnamenode -bootstrapStandby"注:打印很多classpath

启动整个集群检查hdfs和yarn是否成功

32、 关闭整个dfs系统,因为后续需要通过其他途径启动整个集群。

命令:stop-dfs.sh

33、启动整个集群,时间会比较久。

命令:start-all.sh

34、检查hdfs和yarn到底是否成功,现将命令打出来。

命令:hdfs haadmin

35、使用-getAllServiceState这个命令。

命令:hdfs haadmin -getAllServiceState

36、打印yarn的命令行。

命令:yarn rmadmin

37、使用-getAllServiceState这个命令。

命令:yarn rmadmin -getAllServiceState

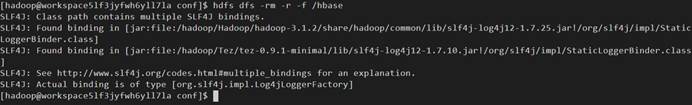

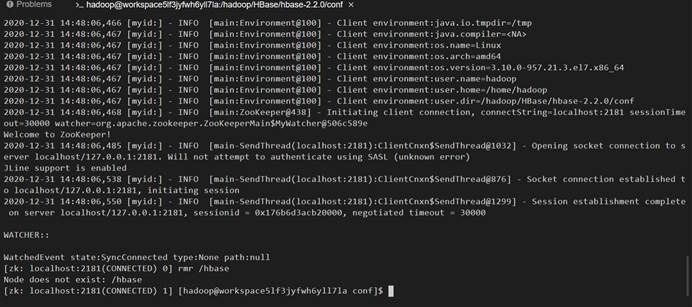

38、验证整个集群,先看一下hdfs上有什么。命令:hdfs dfs -ls /注:hdfs为空

测试hadoop集群是否正常启动

1、为测试方便,创建一个目录。

命令:hdfsdfs -mkdir -p /test/data

2、将所有需要mapreduce数据放在data目录下,将配置文件以xml结尾的上传到data目录里。

命令:hdfs dfs -put /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/*.xml/test/data

3、查看是否上传成功。

命令:hdfsdfs -ls /test/data

4、提交一个mapreduce任务,用hadoop自带的例子。

命令:hadoop jar/hadoop/Hadoop/hadoop-3.1.2/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.2.jargrep /test/data /test/output "dfs[a-z.]+"

注:使用的是grep参数,输入是test/data输出是test/output,这里的output一定不能存在,存在的话用rm命令删除掉。查询以dfs开头的,以小写字母以及.紧接着相邻的很多+字符的字符串。这个命令执行的时候分两步,第一步是查询,查到做正则表达的那一行,然后做排序。

5、整个mapreduce案例已经执行完了,看结果输出什么东西。

命令:hdfs dfs -ls /test/output

注:输出了两个文件,结果在part-r-00000中

6、查看part-r-00000文件中的内容。命令:hdfs dfs -cat /test/output/part-r-00000

注:数字代表出现的次数,字符串是匹配的字符串。

注:数字代表出现的次数,字符串是匹配的字符串。

7、登录管理界面,查看已经执行完的任务。首先点击右侧chrome-browser。

8、再点击vnc_lite.html.

9、单击右键,选择Chrome.

10、输入网址,app-11:8088,会自动跳转到app-12:8088。

常见问题

问题:app-12和app-13的环境变量有问题。解决办法:检查环境变量,如有异常请使用source命令,运行环境变量或者删除workerspace后从头开始创建。

问题:app-12和app-13的环境变量有问题。解决办法:检查环境变量,如有异常请使用source命令,运行环境变量或者删除workerspace后从头开始创建。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

HDFS基本操作

1、运行HDFS看有什么东西。

命令:hdfs

注:主要打印出三类命令,管理命令、客户端命令、管理守护进程命令。

2、命令:hdfs version

注:打印了Hadoop信息、源码信息、编译信息等。

3、命令:hdfs classpath

注:打印classpath

4、命令:hdfs getconf

注:打印getconf下的命令

5、打印namenode。

命令:hdfs getconf -namenodes

注:当前app-12为active.所以将app-12放前面。

6、命令:hdfs getconf -secondaryNameNodes

注:因为我们没有设置secondaryNameNodes,所以现在没有。

7、命令:hdfs getconf -journalNodes

8、命令:hdfs getconf -includeFile

9、命令:hdfs dfs

注:对Linux系统文件的操作。

HDFS文件操作

10、在根目录下创建一个文件。

命令:hdfs dfs -mkdir /test2

11、将test/output/part-r-00000文件拷贝到test2下。

命令:hdfs dfs -cp /test/output/part-r-00000 /test2

12、查看是否拷贝成功。

命令:hdfs dfs -ls /test2

13、先查看本地目录和文件。

命令:pwd、ls

14、下载到本地目录下。

命令:hdfs dfs -get /test2/part-r-00000 ./、 ls

15、可以使用Linux命令查看改文件。

命令:vi part-r-00000

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

今天我学习创建federation环境,viewFS操作,在清理掉这些环境,还原到最初的系统。

创建Federation环境

1、在app-11上,切换到hadoop用户下。

命令:su – hadoop

2、切到hadoop的安装目录下。

命令:cd /hadoop/Hadoop/

3、进入hadoop3.1的配置目录下。

命令:cd hadoop-3.1.2/etc/hadoop/

4、删除hdfs-site.xml文件。

命令:rm -rf hdfs-site.xml

5、进入/tmp/Spark-stack目录下。

命令:cd /tmp/Spark-stack/

6、将hdfs-site.xml拷贝到/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/目录下。

命令:cp hdfs-site.xml /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

注:这里的hdfs-site.xml我们增加了dm2,因为在app-11和app-12上做了ha,dm2只能放在app-13上。

7、将该文件继续拷贝到集群的另外两个机器上。

命令:scp hdfs-site.xml hadoop@app-12:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/、scp hdfs-site.xml hadoop@app-13:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

8、登录到app-13上。

命令:ssh hadoop@app-13

9、切换到配置文件所在的目录下。

命令:cd /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

对namenode各式化。

10、先打开hdfs-site.xml文件。

命令:vi hdfs-site.xml

11、添加注释。将dm2的cluster的namenode限制在app-13上,而不采用ha

12、初始化各式。

命令:hdfs namenode -format -clusterId dm2注:会打印很多classpath

13、启动namenode.

命令:hdfs --daemon start namenode注:只是启动本地的namenode。

14、查看是否开启。

命令:jps

15、将app-13上的datanode和其他机器上的namenode建立联系。

命令:hdfs dfsadmin -refreshNamenodes app-11:9867、hdfs dfsadmin -refreshNamenodes app-12:9867、hdfs dfsadmin -refreshNamenodes app-13:9867

16、退出app-13。

命令:exit

17、查看dfs下有什么。

命令:hdfs dfs -ls /注:这里的输出是dmcluster的。因为在core-site配置文件里defaultFS是dmcluster。

18、如果想要获得dm2的输出需要加一个前缀。

命令:hdfs dfs -ls hdfs://dm2/ 注:这里是空的。

19、创建一个文件夹federation.

命令:hdfs dfs -mkdir hdfs://dm2/federation

20、再次查看目录。

命令:hdfs dfs -ls hdfs://dm2/

21、也可以使用dmcluster前缀查看文件目录。

命令:hdfs dfs -ls hdfs://dmcluster/ 注:这里的文件名前会有目录。

我们需要如何有效的管理这些文件,将这些文件系统挂载到虚拟的文件系统。映射到viewfs系统下。

ViewFS操作

1、进入到hadoop的配置文件下。

命令:cd /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

2、删除core-site.xml文件。

命令:rm -rf core-site.xml

3、切换到/tmp/Spark—stack目录下。

命令:cd /tmp/Spark-stack/

4、将core-site.xml拷贝到hadoop配置文件下。

命令:cp core-site.xml /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

5、将文件拷贝到集群的另外两个机器上。

命令:scp core-site.xml hadoop@app-12:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/、

scp core-site.xml hadoop@app-12:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

6、不需要重新启动集群,view就可以生效。

命令:hdfs dfs -ls /

注:此时所访问的是view的根目录。hadoop和user是dmcluster里的目录,federation是dm2里的目录。这样我就有效的管理了我们集群。

因为后续的操作不需要做federation和view,所以我们更改回去。

还原配置文件

1、先删除core-site.xml、hdfs-site.xml

命令:rm -rf core-site.xml hdfs-site.xml

2、切换到/tmp/Spark-stack/initialization目录下。

命令:cd /tmp/Spark-stack/initialization/

3、将core-site.xml hdfs-site.xml两个文件拷贝到hadoop的配置文件下。

命令:cp core-site.xml hdfs-site.xml /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

4、将配置文件拷贝到集群的另外两台机器上。

命令:scp core-site.xml hdfs-site.xml hadoop@app-12:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/、

scp core-site.xml hdfs-site.xml hadoop@app-13:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

5、登录到app-13。

命令:ssh hadoop@app-13

6、停止namenode。

命令:hdfs --daemon stop namenode

7.查看是否关闭。

命令:jps

8、退出app-13。

命令:exit

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

MR基本用例

下载程序

1、切换到hadoop用户下。

命令:su – hadoop

2、查看集群是否正常工作。

命令:jps

3、切换到/tmp目录下,并创建mr文件。注:这个mr是之前在做Java例子时创建的,现在可以删除掉。

命令:cd /tmp/、mkdir mr

4、进入Spark-stack/Hadoop/目录下。

命令:cd Spark-stack/Hadoop/

5、将WordCount程序拷贝到/tmp/mr/目录下。

命令:cp -r WordCount/* /tmp/mr/

6、打开org/apache/hadoop/examples目录下的WordCount.java文件。

命令:vi org/apache/hadoop/examples/WordCount.java

7、因为现在是hadoop的集群环境中编译程序,而不是在idea中导出jar包,需要把包的信息注释。

代码解释

解析输入函数的输入参数、输入的路径、输出的路径。 创建Job,代表MapReduce的整个过程。

将多个输入文件或者路径加到job中

将多个输入文件或者路径加到job中

Key为行号、value为给map的每一行的字符串、context定义整个上下文环境。首先现将value变成string,再通过StringTokenizer方法变成一个个的单词存放在word中,再将word中出现的单词和频次存放到context中。

已经将map中的相同的key的内容集合到一起。将同一个key的多个做map的结果进行一个求和。

编译

1、设置环境变量HADOOP_CLASSPATH。

命令:export HADOOP_CLASSPATH=${JAVA_HOME}/lib/tools.jar

2、因为Java文件存放在WordCount/org/apache/hadoop/examples/目录下,所以进入该目录下。

命令:cd org/apache/hadoop/examples/

3、进行编译。

命令:hadoop com.sun.tools.javac.Main WordCount.java注:会出现很多class文件。

4、将class文件打包,打包成一个可以执行的jar包。

命令:jar cf WordCount.jar WordCount*.class

运行MapReduce

1、查看目录。

命令:hdfs dfs -ls /注:有一个安装路径installTest。

2、查看installTest目录。

命令:hdfs dfs -ls /installTest

3、查看hadoop目录。

命令:hdfs dfs -ls /installTest/Hadoop 注:data目录就是在安装时的目录,output是之前在做hadoop安装测试时的mapreduce任务。

4、查看data目录。

命令:hdfs dfs -ls /installTest/hadoop/data

5、提交MapReduce程序。

命令:hadoop jar WordCount.jar WordCount /installTest/hadoop/data /installTest/hadoop/output3 注:输入是/installTest/hadoop/data,输出是/installTest/hadoop/output3,确保输出是不存在的。map需要缓步启动,reduce需要map启动完才运行。

6、查看结果。

命令:hdfs dfs -ls /installTest/hadoop/output3

7、结果在part-r-00000文件里。查看该文件。

命令:hdfs dfs -cat /installTest/hadoop/output3/part-r-00000

前面的字符串是输入数据也就是data里出现过的字符串,数字是出现的次数。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

Wordcount例子Python版本

下载程序

1、登录hadoop用户下。

命令:su - hadoop

2、进入到tmp目录下。

命令:cd /tmp/

3、将mr是运行Java例子创建,我需要将mr全部删除。

命令:rm -rf mr/

4、再创建mr。

命令:mkdir mr

5、进入Spark-stack/Hadoop/目录。

命令:cd Spark-stack/Hadoop/

6、将WordCount-python文件拷贝到mr目录下。

命令:cp -r WordCount-python/* /tmp/mr/

7、确保Python正常安装。

命令:python –-version 注:我们的Python是2.7.5版本。

8、寻找streaming.jar的位置。

命令:find /hadoop/Hadoop/hadoop-3.1.2 -name "*streaming*.jar" 注:在hadoop的安装文件里寻找以streaming包括streaming,以.jar为结尾的文件。

9、在运行之前我们需要找到数据存储目录。

命令:hdfs dfs -ls /

10、数据存储在installTest/hadoop目录下。

命令:hdfs dfs -ls /installTest/Hadoop

11、进入到/tmp/mr目录下。

命令:cd /tmp/mr

12、在正式提交集群之前,我们可以做一个简单的测试,验证Python脚本的正确性。

命令:cat /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/hdfs-site.xml | python WordCountMapper.py | sort | python WordCountReducer.py注:以hadoop的配置文件hdfs-site.xml为输入,依次运行Mapper、排序和Reducer

代码简析

从stdin中读取文本信息,将多余的空格去掉,化成一个个的单词,遍历每个单词,输出到流里。

从stdin中读取mapper的输出,再对相同key的value值累加,然后打印出每一个key总数。

运行

1、进行运行。

命令:hadoop jar hadoop/Hadoop/hadoop-3.1.2/share/hadoop/tools/lib/hadoop-streaming-3.1.2.jar \、> -input /installTest/hadoop/data -output /installTest/hadoop/output5 \、> -file /tmp/mr/WordCountMapper.py -file /tmp/mr/WordCountReducer.py \、> -mapper WordCountMapper.py -reducer WordCountReducer.py

注:首先找到jar文件,空格加\可以多行输入,输入是data目录,输出是output5,确保输出目录是不存在的,将Mapper和Reducer放到文件缓存中,最后定义Mapper和Reducer。

2、先找到执行结果的文件。

命令:hdfs dfs -ls /installTest/hadoop/output5

3、查看执行结构文件。

命令:hdfs dfs -cat /installTest/hadoop/output5/part-00000

字符串是data输入中的字符串,数字是字符串出现的次数。

友情提示:详细学习内容可观看Spark快速大数据处理——余海峰https://edu.csdn.net/course/detail/24205

MapReduce基本原理

输入数据是怎么来的

Hadoop将我们的输入数据划分为等长的数据块,被称为输入的分片,Hadoop为每个分片构建一个map任务,并用该任务来运行用户自定的map函数来处理分片中的每一条记录,map结果就是每一条记录输出的结果。

负载均衡

每个分片所需的时间少于处理输入数据所花的时间。因此,如果并行的处理每个分片,且每个分片的数据比较,那么整个处理过程将获得更好的负载均衡。因为我们一台快计算机它能够处理的数据分片肯定比一台慢的计算机处理的多,而且成一定的比例。如果说,我们把输入分片分的比较细,那么这样,可以达到某种负载均衡或者多的可以承载多的,少的承载少的。但是,如果我们的分片比较大,那么我们就会卡死在这个节点上。比如说,有10个分片需要承载,要用1为单位的承载,可以承载为10份;如果用3为单位的承载,3份还多1份,没法平均起来。也就是分片要小,我们才能做的更好的负载均衡。如果输入分片太小,这个整个输入性能不一定越好,因为在管理分片,在运行map任务的时间可能比处理分片的时间还要多,那么,就是相当于拣了芝麻丢了西瓜,那么这个分片过小,在这里是不划算的。那要怎么样才能产生一个均衡的结果,之前讲的HDFS文件是分为许多的数据块,数据块是承载在DataNode节点上。比如说,每个数据块都是128兆、64兆这种数据块是比较大的,因为我们面临的问题是大数据集的情况,且每个数据块将占用我们NameNode的一部分资源,将数据块切的太小,我们将会受到一定的损失,特别是NameNode的性能损失,所以我们要适中,这是架构层面的考虑。而且Map做的时候都是本地化,什么是数据本地化,在做大数据处理的时候,要借用本地化的处理措施来获得性能,在前面我们的hadoop3的目标中我们讲过,计算要尽可能的靠近数据,而且计算搬移的性能较为容易一些,数据很难搬移。那么最恰当的目标是将计算分布在数据所处理的节点上,那么Map可以达到这个目标。我们在数据所在的节点上执行Map线程将数据存储在节点所在的缓存里。因此就可以在Map端节约网络资源,集群的带宽资源。此外,还要明确一个概念,为什么最佳的分片大小和块的大小相同,而不是和两个块的大小?是因为,如果分片跨越两个数据块任何一个HDFS节点基本上不可能同时存储这两个数据块,因为对于任何HDFS节点也就是DataNode不可能有同时存储两个数据块,这个数据可靠性的要求。

MapReduce优点

1、可以在MapReduce里的job中设置combiner。 2、Map将数据存在本地的系统里,这个过程并不是简单的写到磁盘。在我们软件设计里面就会经常用的这一点,就是有一个循环的缓冲区,这个缓冲区是内存的,它的速度和性能比磁盘的要高,在每一个Map任务的机器上我们设置一个循环的缓冲区,将Map的结果写到缓冲区,当这个缓冲区写满之后,再将写到溢出到文件里面去,这个过程是可以控制的,每个缓冲的区的大小,都是可以控制的。 3、Reduce的过程就相当于先做拷贝再做计算,在拷贝的过程就是做一个合并,是一个逐步的拷贝,因为在Map的过程就是缓慢的,合并次数可以设定。

MapReduce内部机制

程序过程

输入有三个切片,对应的map结果是分别是:Dear,1、Hello,1、World,1和World,1、Hello,3、Dear,2以及World,1、Hello,2、World,1。当我们的shuffle进程完成之后,我们的数据已经get到了,比如dear1和dear2,为了减少数据传输量,在我们做work的时候,将dear1和dear2做一次运算,那么只传输一条记录dear3,做这项功能的叫combiner。之后有两个sort,by key和by value第一个sort是根据key做排序,第二个sort是根据value做排序,做完sort之后,送到给reduce,reduce在将数据写到output里面。

程序原理

如果将两个数据块分配同一个Map那么将可能产生网络的传输,会降低Map传输的性能。虽然将数据存在了Map的DataNode的本地节点,也就是Map放在的本地的文件系统里。而不是HDFS中,这是因为HDFS需要存到用于备份,这样又产生了网络层的数据传输,所以说,将Map的结果存到本地的文件系统里面。因此,Reduce任务需要有一个shuffle过程,就是混洗过程。混洗过程会产生一个网络传输,混洗的过程将Map所在的节点上的结果数据,拷贝到Reduce所在的节点上。而且,因为有多个Reduce,每个Reduce要处理Map结果的子集。因为Map结果有很多的key,需要有一个分区器,把Map结果挂分到Reduce上,也就是选取那些key给哪一个Reduce,在这个分区环节已经确定了。同时这也是Map和Reduce这两个函数的耦合点,因为在做Map的时候,需要知道,这个分区是怎么样做的。所以说, Map的输出要做分区,有了个这个分区之后哪些Map需要送达给哪个Reduce,或者反过来说,我们的shuffle这些线程才能够知道我们去取哪些分区给哪一个Reduce。 在之间做的例子中,输出文件中会有一个part -r -00000结果文件,既然有00000文件,肯定也会有00001文件,是因为做一个Reduce那么就会输出一个结果,相当于输出了一个结果的分区,所以会有多个part-r的输出。

关键总结

1,排序(Shuffle 阶段):排序是MapReduce的默认行为,两次排序行为:第一次在Map的环形缓冲区中(排序后分区),第二次在Reduce的合并切片数据后(排序后分组) 2,分区(Shuffle 阶段):确保相同key的数据分到同一个Reduce中3,分组(Reduce阶段):确保相同key的数据进入同一个reduce()方法迭代器中 4,合并(Shuffle 阶段):把所有溢写的临时文件进行一次合并操作,以确保一个Map 最终只产生一个中间数据文件。 5,多次写磁盘的时机:1、多次溢写的小文件;2、小文件排序合并;3、分区后形成的数据块等待Reduce拉取;4、Reduce拉取每台map所在机器上的数据块;5、Reduce合并所有的数据块进行排序分组

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Hadooop1.0时代

由于Hadoop1.0良好特性,比如说bat,Facebook,雅虎等都在大数据处理系统中用了Hadoop,但是随着Hadoop1.0使用的日益丰富,用的越来越多了,那么原来的Hadoop1.0中存在的问题逐渐暴露出来。主要体现在四个方面。

SPOF

第一个方面单点故障。因为Hadoop1.0时候NameNode和JobTracker设计成单一结点。JobTracker是提交任务的管理者,但是它是单节点,一旦该节点出现故障对整个系统产生致命性影响。因为NameNode和JobTracker放在了一起,这严重制约了Hadoop的可可展性和可靠性。因为我们是在生产环境中使用,如果不能做到高可靠,我们的生产系统很难做到大规模推广。随着我们的业务越来越多,所部署的大数据系统不可能就放一个业务,而是有一个任务队列,在任务队列中也有许多的任务,随着JobTracker的业务增长,处理任务也随着增长同时内存消耗过大也会产生一些任务失败的情况,那么单节点就将大规模的应用给堵死了。

Only MR

第二个方面是仅仅支持MapReduce。这个计算模式比较单一。然而在现实业务中存在很多的需求,比如,对实时业务及时处理就产生了Storm和Spark。需要图的处理,图是计算机里非常重要的数据结构抽象,也需要这种处理模式。这些就不仅仅是MapReduce可以解决的处理框架。那么怎么样整合这些处理框架,数据在Hadoop中,不能将计算搬移到数据所在的节点上,那么框架的应用会受到很大的限制。

MR Slot

第三个方面是MapReduce框架不够灵活。因为Map和Reduce绑得太死,先进行Map再进行Reduce中间有个Shuffle,这个作为整个Map和Reduce的耦合点之一。因为Map和Reduce作为一个整体给用户使用的,但是,并不是每个业务都需要同时操作,有时只需要其中之一。但是Hadoop1.0中TaskTracker将任务分解为Map Tracker Slot和Reduce Tracker Slot。Slot在大数据的理解为分配的资源词,从硬件的Slot抽象到软件的Slot。如果,当前节点只存在Map或者只存在Reduce这种任务,需要同时分配两个插槽也就是两个Slot,这样就会造成资源浪费,因为只有单一的Map和单一的Reduce。

RM

最后一个方面是资源管理不灵活,因为采用的是静态Slot分配措施,就是在任务提交分析完之后,Slot已经分配了,而且在每个节点启动前为每个节点配置好Slot总数,一旦启动后就不能动态更改,并且Map Slot和Reduce Slot不允许交换。

YARN架构

Yarn有三个组件,分别为Resource Manager、Node Manager和Application Master。Resource Manager是管理器的核心组件,采用的是主从结构,负责所有资源的监控、分配和管理。Application Master负责每个应用程序的调度和协调。Node Manager负责本节点资源的维护。因为所有的程序都要跑在每一个节点上,做底层工作的是Node Manager,因为Node Manager上有很多的Container去跑计算机任务。 Resource Manager需要获取Node Manager的情况,Container需要向Application Master汇报情况。

Flink运行在Yarn上

可以将Flink理解为某个计算任务。首先向Flink计算框架提交任务,在Flink框架里有YARN的客户端,Flink将其他的资源打包成Uberjar先提交给HDFS,HDFS是整个集群所能共享的相当于一个缓存。然后,向YARN Resource Manager申请am,am是处理层的管理者。申请一个项目协调小组,由一个总的Container控制,下分许多单个Container。将任务的执行文件也就是Uberjar拷贝到本地执行,执行完之后,或者执行的过程中,向总的Container汇报情况。由此可见,YARN将任务协调交给了应用程序的本身。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

1、在app-11上以hadoop用户登录。

命令:su - hadoop

2、输入yarn命令。

命令:yarn注:三类命令,管理命令、客户端命令、守护进程命令

3、展示所有关于node的命令。

命令:yarn node

4、将集群的所有信息打印出来。

命令:yarn node -list -all注:包括节点信息、节点状态、节点地址、节点上的Containers

5、管理命令。

命令:yarn rmadmin

6、查看所有的service状态。

命令:yarn rmadmin -getAllServiceState

7、管理application的命令。

命令:yarn app

8、命令:yarn app -list

注:因为还没有提交任务,所有现在list结果为空。

9、查看环境变量。

命令:yarn envvars

10、运行jar文件。

命令:yarn jar

11、查看yarn版本。

命令:yarn version

12、打印需要得到Hadoop的jar和所需要的lib包路径。

命令:yarn classpath 注:这里的classpath和hdfs是一样的。

13、动态展现yarn的执行情况。

命令:yarn top注:将CPU、内存使用情况、任务完成情况打印出来

14、按Ctrl+c退出当前状态。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

RM HA配置文件详解

1、启动resourcemanager的ha。

2、对集群进行命名。

3、配置resourcemanager的ids,可以定义多个,在本地就定义了两个rm1和rm2。

4、做ha是通过zookeeper协调组件,需要定义zookeeper的地址。

5、将虚拟机的检验工作禁止。

6、配置resourcemanager的hostname和address。

手动切换active和standby

1、确保集群正常启动。

命令:jps

2、将resourcemanager的rm1变为Standby,因为之前查看的rm1是active。

命令:yarn rmadmin -transitionToStandby rm1 --forcemanual

3、选择Yes。

命令:Y

4、检查集群的情况。

命令:yarn rmadmin -getAllServiceState

5、再将rm2变为active状态。

命令:yarn rmadmin -transitionToActive --forceactive --forcemanual rm2

再输入Y

6、再次检查集群的情况。

命令:yarn rmadmin -getAllServiceState

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Yarn调度器配置

理想情况下,我们应用对Yarn资源的请求应该立刻得到满足,但现实情况资源往往是有限的,特别是在一个很繁忙的集群,一个应用资源的请求经常需要等待一段时间才能的到相应的资源。在Yarn中,负责给应用分配资源的就是Scheduler。其实调度本身就是一个难题,很难找到一个完美的策略可以解决所有的应用场景。

在Yarn框架中,调度器是一块很重要的内容。有了合适的调度规则,就可以保证多个应用可以在同一时间有条不紊的工作。最原始的调度规则就是FIFO,即按照用户提交任务的时间来决定哪个任务先执行,但是这样很可能一个大任务独占资源,其他的资源需要不断的等待。也可能一堆小任务占用资源,大任务一直无法得到适当的资源,造成饥饿。

为了解决以上问题,yarn提供了两种调度器,分别为:容量调度器和公平调度器。

容量调度器

原理

针对多用户调度,容量调度器采用的方法稍有不同。集群由很多队列组成,这些队列可能是层次结构的(因此,一个队列可能是另一个队列的子队列),每个队列被分配有一定的容量。本质上,容量调度器允许用户或组织为每个用户或组织模拟出一个使用FIFO调度策略的独立集群。容量调度器说的通俗点,可以理解成一个个的资源队列。这个资源队列是用户自己去分配的。

配置文件改动

1、调度器所占的最大份额设置为0.5。如果分配的过小,一个任务大概3G的内存,am会一直在等待过程中,无法进行下去。

2、root的队列是default,default的容量是100%,所有的任务都在同一个队列里面。

容量调度器演示

1、将default队列的情况打印出来。

命令:yarn queue -status default注:包括状态、容量、当前的容量、最大的容量

公平调度器

原理

公平调度器的目标是让每个用户公平共享集群能力。如果只有一个作业在运行,就会得到集群的所有资源。随着提交的作业越来越多,闲置的任务就会以“让每个用户公平共享集群”这种方式进行分配。某个用户的耗时短的作业将在合理的时间内完成,即便另一个用户的长时间作业正在运行而且还在运行过程中。

将整个集群资源都分配给应用程序,当提交其他应用程序的时候,已经释放的资源分配给新的应用程序。因此,每个应用程序最后都能粗略的获得等量的资源。

代码解释

Client向Resource Manager申请资源运行ApplicationMaster,ApplicationMaster向Node Manager申请资源也就是container,这里我们申请了10个container,去运行javaPi程序。

Client.java

1、创建Yarn的Client端,启动Yarn的Client端。

2、用YarnClient创建Application,得到application的上下文。注意,在Yarn中不允许提交相同名字的应用程序。

3、设置am的资源申请量,1G和一核。

4、设置application的环境变量。

ApplicationMaster.java

1、创建AMRMClient端,Application Master要向Resource Manager申请资源。

2、创建nmClient端,是向Node Manager交互的客户端。

3、向RM注册心跳信息。

4、申请container。

Yarn编程实战

下载程序

1、在app-11上,确保集群是启动的。

命令:jps

2、切换到tmp目录下。

命令:cd /tmp

3、创建yarn文件。

命令:mkdir yarn

4、进入程序所在的文件夹下。

命令:cd Spark-stack/yarnExample/src/main/

5、将Java文件拷贝到新建的yarn文件夹下。

命令:cp -r java/* /tmp/yarn/

6、进入yarn目录下。

命令:cd /tmp/yarn/

编译程序

7、确定tools.jar存在。

命令:export HADOOP_CLASSPATH=${JAVA_HOME}/lib/tools.jar

8、使用hadoop命令编译程序。

命令:hadoop com.sun.tools.javac.Main org/apache/hadoop/yarn/examples/*.java注:程序文件在examples目录下,编译.java文件。

9、查看examples目录下。

命令:ls org/apache/hadoop/yarn/examples/

注:会出现许多的class文件。

10、将class文件打包。

命令:jar cf app.jar org/apache/hadoop/yarn/examples/*.class

打开程序应用状态监视

11、new terminal,之后使用hadoop用户登录。

命令:su – hadoop

12、监视。

命令:yarn top

运行程序

13、返回之前的new terminal,使用hadoop命令提交程序。

命令:hadoop jar app.jar org.apache.hadoop.yarn.examples.Client 注:程序会一直运行下去,一直获取appID的情况。

Top的监视结果。

14、按Ctrl+c停止程序。

查看打印

15、新建new terminal,hadoop用户登录。

命令:su – hadoop

16、javaPi打印,先进入hadoop-3.1.2/logs目录下。

命令:cd /hadoop/Hadoop/hadoop-3.1.2/logs/

17、在进入userlogs目录下。

命令:cd /hadoop/Hadoop/hadoop-3.1.2/logs/userlogs/

注:这里有所有的执行container任务。

18、进入application_1602472376409_0001目录下。

命令:cd application_1602472376409_0001/注:app-11上有两个个container,分别为02和06.

查看其它机器的container

19、在app-12上,hadoop用户登录。

命令:su – hadoop

20、进入application_1602472376409_0001目录下。

命令:cd/hadoop/Hadoop/hadoop-3.1.2/logs/userlogs/application_1602472376409_0001/ 注:这里的container有三个。

21、在app-13上,hadoop用户登录。

命令:su – hadoop

22、进入application_1602472376409_0001目录下。

命令:cd/hadoop/Hadoop/hadoop-3.1.2/logs/userlogs/application_1602472376409_0001/ 注:这里的container有四个。

23、随机查看一个contain的运行结果。

命令:cat container_1602472376409_0001_01_000009/stdout

常见问题

问题解释:在javaPi中有些字符串不识别,这里是注释的中文不识别。 问题解决:将javaPi中的中文解释删除。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

作业

1、独立完成Hadoop HA集群的搭建与验证。

为什么选择Tez

为什么要用Tez

在分布式系统中要存储海量的数据,因为构建了一个非商务的机器上能够运行的hdfs分布式存储空间,而且这个存储空间是低成本的并且具有良好的扩展性。那么,很多企业都会将海量的存储数据迁移到Hadoop上,而摒弃之前用的ioe方式。然后,在利用Hive和Pig提供的类SQL语句完成我们的大规模的数据处理,以应对数据挖掘以及数据准备的应用场景。为什么这么选择,是因为存储廉价和开发人员是相对丰厚的。Hive和Pig如果需要通过MapReduce进行处理的话,那么解决问题的实时性得不到满足。

Tez在大数据架构的层次图

数据存储,如果有一个交互式查询任务,Tez负责通过Hive或者Pig等转化为Tez有向无环图的执行方式去执行查询,然后将查询的任务提交到YARN。Spark和Flink有自己的结构框架提交YARN。

数据存储,如果有一个交互式查询任务,Tez负责通过Hive或者Pig等转化为Tez有向无环图的执行方式去执行查询,然后将查询的任务提交到YARN。Spark和Flink有自己的结构框架提交YARN。

之所以还继续选择Tez框架,是因为Tez可以做为底层的计算框架,可以集成在YARN上。

MapReduce和Tez对比

这幅图展示了进入MR和进入Tez的Pig/Hive查询架构、性能的对比。蓝色的块代表做Map,绿色的块代表做Reduce,一个圆圈表示做了一个完整MapReduce的job,连接圆圈之间是结果输出到hdfs中。左侧图中做了四个MapReduce的任务,关系是树,有三次hdfs的写入。在右侧中只有一次写入hdfs,将最终的结果写入。

性能对比

Query27、Query82、Query52、Query55、Query12是查询的种类。

Tez特征

1、分布式执行框架,面向大规模数据处理应用的分布式数据查询的引擎,包含:分布式计算的数据处理框架、可以集成到YARN底层透明的给应用提供执行框架。

2、基于将计算表示为数据流图。

3、构建在YARN之上——Hadoop的资源管理框架。

4、简化部署。

5、数据类型不可知。

6、动态物理数据流决策。

7、运行时计划重新配置。

Tez基本架构

这是逻辑图,Tez是进入DAG的,所以要创建一个DAG。之后创建每个节点,创建每个节点之间的编。

这是物理图,在实际的应用中会有多个并行实例。在实际的物理部署中Tez采用SGather形式将数据发射出去,由Bipartie去拉取需要的数据。

这种执行需要Tez的执行引擎做调度。DAG的执行引擎包括了三个主要部分,两个调度器一个管理者。Vertex Manager将逻辑计算图形式转化为tasks形式。有多个job就会有对应的多个DAG调度器,Task调度器要调度每个计算图的Hadoop集群的物理节点上执行的时间。

左侧图是从Application Master整个集群框架的视角看,DAG的执行过程。通过Client端去提交DAG,提交之间会进行start Session,Session和Application Master交互,向Application Master提交任务,Application Master在YARN集群上。然后Application Master去管理Container Pool(容器的池)。

右侧图是AM承担的重要角色处理信息,通过AM去处理各个Task,因为Task之间是无法直接交流的。比如,Map Task2做完任务有Data Event的输出,需要告诉AM,AM中的Router(相当于路由器)将数据路由到Reduce Task2上。路由的过程并不是在Map Task2的物理节点上拷贝到AM上然后再发送给Reduce Task2所在的节点上,而是提供了一个路由功能,是控制信息的路由,数据是直达的。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

为什么选择Tez

为什么要用Tez

在分布式系统中要存储海量的数据,因为构建了一个非商务的机器上能够运行的hdfs分布式存储空间,而且这个存储空间是低成本的并且具有良好的扩展性。那么,很多企业都会将海量的存储数据迁移到Hadoop上,而摒弃之前用的ioe方式。然后,在利用Hive和Pig提供的类SQL语句完成我们的大规模的数据处理,以应对数据挖掘以及数据准备的应用场景。为什么这么选择,是因为存储廉价和开发人员是相对丰厚的。Hive和Pig如果需要通过MapReduce进行处理的话,那么解决问题的实时性得不到满足。

Tez在大数据架构的层次图

数据存储,如果有一个交互式查询任务,Tez负责通过Hive或者Pig等转化为Tez有向无环图的执行方式去执行查询,然后将查询的任务提交到YARN。Spark和Flink有自己的结构框架提交YARN。

数据存储,如果有一个交互式查询任务,Tez负责通过Hive或者Pig等转化为Tez有向无环图的执行方式去执行查询,然后将查询的任务提交到YARN。Spark和Flink有自己的结构框架提交YARN。

之所以还继续选择Tez框架,是因为Tez可以做为底层的计算框架,可以集成在YARN上。

MapReduce和Tez对比

这幅图展示了进入MR和进入Tez的Pig/Hive查询架构、性能的对比。蓝色的块代表做Map,绿色的块代表做Reduce,一个圆圈表示做了一个完整MapReduce的job,连接圆圈之间是结果输出到hdfs中。左侧图中做了四个MapReduce的任务,关系是树,有三次hdfs的写入。在右侧中只有一次写入hdfs,将最终的结果写入。

性能对比

Query27、Query82、Query52、Query55、Query12是查询的种类。

Tez特征

1、分布式执行框架,面向大规模数据处理应用的分布式数据查询的引擎,包含:分布式计算的数据处理框架、可以集成到YARN底层透明的给应用提供执行框架。

2、基于将计算表示为数据流图。

3、构建在YARN之上——Hadoop的资源管理框架。

4、简化部署。

5、数据类型不可知。

6、动态物理数据流决策。

7、运行时计划重新配置。

Tez基本架构

这是逻辑图,Tez是进入DAG的,所以要创建一个DAG。之后创建每个节点,创建每个节点之间的编。

这是物理图,在实际的应用中会有多个并行实例。在实际的物理部署中Tez采用SGather形式将数据发射出去,由Bipartie去拉取需要的数据。

这种执行需要Tez的执行引擎做调度。DAG的执行引擎包括了三个主要部分,两个调度器一个管理者。Vertex Manager将逻辑计算图形式转化为tasks形式。有多个job就会有对应的多个DAG调度器,Task调度器要调度每个计算图的Hadoop集群的物理节点上执行的时间。

左侧图是从Application Master整个集群框架的视角看,DAG的执行过程。通过Client端去提交DAG,提交之间会进行start Session,Session和Application Master交互,向Application Master提交任务,Application Master在YARN集群上。然后Application Master去管理Container Pool(容器的池)。

右侧图是AM承担的重要角色处理信息,通过AM去处理各个Task,因为Task之间是无法直接交流的。比如,Map Task2做完任务有Data Event的输出,需要告诉AM,AM中的Router(相当于路由器)将数据路由到Reduce Task2上。路由的过程并不是在Map Task2的物理节点上拷贝到AM上然后再发送给Reduce Task2所在的节点上,而是提供了一个路由功能,是控制信息的路由,数据是直达的。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

编译Tez

由于在Tez-Yarn的官网上并没有关于hadoop3.1.2对应的Tez-Yarn安装包,所以我们进行针对性的编译。先检测Maven是否安装了。

修改pom.xml

编译modules,将tez-ui注释掉,不需要编译tez-ui。

检测Maven是否安装

1、在app-11上,使用hadoop用户登录。

命令:su - hadoop

2、检测Maven是否安装。

命令:mvn -version

3、进入cd/hadoop/tools/目录下。

命令:cd /hadoop/tools/

4、这里没有Maven,下载Maven。

命令:wget http://archive.apache.org/dist/maven/maven-3/3.6.0/binaries/apache-maven-3.6.0-bin.tar.gz

5、解压。

命令:tar -xf apache-maven-3.6.0-bin.tar.gz

6、在环境变量中加入MAVEN_HOME路径。

命令:vi ~/.bashrc

exportMAVEN_HOME=/hadoop/tools/apache-maven-3.6.0

export PATH=${MAVEN_HOME}/bin:$PATH

7、将新添加的环境变量生效。

命令:source ~/.bashrc、echo $PATH

8、查看Maven是否安装成功。

命令:mvn -version

下载编译程序

9、切到tmp目录下。

命令:cd /tmp/

10、创建tez文件。

命令:mkdir tez

11、进入Spark-stack/Tez目录下。

命令:cd Spark-stack/Tez

12、将buildTez下的内容拷贝到tez目录下。

命令:cp buildTez/* /tmp/tez/

13、切换到tez目录下。

命令:cd /tmp/tez/

14、解压apache-tez-0.9.0-src.tar.gz。

命令:tar -xf apache-tez-0.9.0-src.tar.gz

15、将pom.xml拷贝到源码目录下。

命令:cp pom.xml apache-tez-0.9.0-src

16、进入源码目录。

命令:cd apache-tez-0.9.0-src

编译

17、开始编译。

命令:mvn -X clean package -DskipTests=true -Dhadoop.version=3.1.2 -Phadoop28 -P!hadoop27 -Dprotoc.path=/hadoop/tools/protobuf-2.5.0/bin/protoc -Dmaven.javadoc.skip=true

注:使用hadoop3.1.2版本,不使用2.7版本。同时在tools里面安装了protobuf组件,将path写在这个命令行上,并且不进行测试。编译的时间是9分钟。显示每个模块相关的编译耗时。

18、安装包在tez-dist目录下。

命令:cd tez-dist/

19、进入target目录。

命令:cd target/ 注:有了tez-0.9.1-minimal.tar.gz和tez-0.9.1.tar.gz这两个包证明编译成功。

安装有两种方式,第一种是先进行编译,将编译出来的安装包拷贝到集群上,命令:cp tez-0.9.1-minimal.tar.gz tez-0.9.1.tar.gz /安装tez的路径。第二种是github上有对应的安装包,直接下载到对应的位置。

安装

修改hadoop-env.sh

增加了三个配置。

修改mapred-site.xml

将mapreduce框架改为yarn-tez。

增加tez-site.xml tez.lib.uris指向/user/tez/tez-0.9.0.tar.gz。

下载安装包

1、返回根目录。

命令:cd

2、检查集群是否正常启动。

命令:jps

3、在hadoop根目录下创建tez安装文件。

命令:mkdir /hadoop/Tez

4、进入Spark-stack/Tez目录下。

命令:cd /tmp/Spark-stack/Tez/

5、这是直接在GitHub上下载安装包。Tez安装包在apache-tez-0.9.0-bin目录下,将该目录下的安装拷贝到安装Tez目录下。

命令:cp apache-tez-0.9.0-bin/* /hadoop/Tez/

6、进入安装Tez目录下。

命令:cd /hadoop/Tez/

将tez-0.9.0.tar.gz上传到hdfs中

7、先创建tez目录。

命令:hdfs dfs -mkdir /user/tez

8、将安装包上传到tez目录下。

命令:hdfs dfs -put tez-0.9.0.tar.gz /user/tez/

9、查看是否上传成功。

命令:hdfs dfs -ls /user/tez/

10、进入hadoop的配置文件。

命令:cd /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

11、将mapred-site.xml和hadoop-env.sh文件删除。

命令:rm -rf mapred-site.xml hadoop-env.sh

将配置文件拷贝到集群的各个机器上

12、进入Spark-stack/Tez/目录下。

命令:cd /tmp/Spark-stack/Tez/

13、将配置文件拷贝到hadoop的配置文件下。

命令:cp -r conf/* /hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

14、将配置也拷贝到app-12和app-13上。

命令:scp -r conf/* hadoop@app-12:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/、 scp -r conf/* hadoop@app-13:/hadoop/Hadoop/hadoop-3.1.2/etc/hadoop/

注:因为scp是覆盖拷贝所以不需要删除。

解压tez-0.9.0-minimal.tar.gz

15、进入Tez安装目录。

命令:cd /hadoop/Tez/

16、创建tez-0.9.0-minimal。

命令:mkdir tez-0.9.0-minimal

17、将tez-0.9.0-minimal.tar.gz解压到tez-0.9.0-minimal。因为在hadoop-env.sh中添加的TEZ_JARS在tez-0.9.0-minimal目录下。

命令:tar -xf tez-0.9.0-minimal.tar.gz -C tez-0.9.0-minimal

18、进入到tez-0.9.0-minimal目录下。

命令:cd tez-0.9.0-minimal

集群重启

19、先停止集群。

命令:stop-all.sh

20、登录app-12上停止historyserver。

命令:ssh app-12 "mapred --daemon stop historyserver"

21、检查启动的集群。

命令:jps 注:除了zookeeper进程在启动没有其他进程。

22、登录其他的机器确保只有zookeeper进程。

命令:ssh app-12 "jps"、ssh app-13 "jps"

23、启动hadoop集群。

命令:start-all.sh

24、重新启动app-12上的historyserver。

命令:ssh app-12 "mapred --daemon start historyserver"

25、使用jps检查集群。

命令:jps注:NameNode、NodeManager、ResourceManager均已经启动了。

测试

26、查看tez-0.9.0-minimal目录。

命令:ls注:用这里的example做测试。

27、查看hdfs的目录。

命令:hdfs dfs -ls/

28、做测试的输入是做hadoop安装时做测试的文件。这个文件在/installTest/hadoop/data目录下,先查看该目录的文件。

命令:hdfs dfs -ls /installTest/hadoop/data

29、MapReduce测试。

命令:hadoop jar tez-examples-0.9.1.jar orderedwordcount /installTest/hadoop/data /installTest/hadoop/output3

注:hadoop jar运行tez-examples-0.9.1.jar然后运行tez-examples-0.9.1.jar里的orderedwordcount命令。orderedwordcount的含义是不仅要进行wordcount还要根据word进行排序。输出是/installTest/hadoop/data,输出是/installTest/hadoop/output3,确保输出文件不存在即可

30、查看输出的文件。

命令:hdfs dfs -ls /installTest/hadoop/data /installTest/hadoop/output3

31、输出的结果在part-v002-o000-r-00000中。

命令:hdfs dfs -cat /installTest/hadoop/data /installTest/hadoop/output3/part-v002-o000-r-00000

注:结果是按照value排序的。

常见问题

问题解释:环境变量执行缓慢。

解决办法:多次进行source命令,更新环境变量。

逻辑DataFlow

Source就是hdfs的文件,经过map,tokenizer顶点相当于map,做完map就可以输出单词加上1,这样的keyvalue键值对。然后对键值对求和,因为这里的求和之后需要排序,所以求和的过程不像MapReduce直接做Reduce,Reduce之后将value和key进行交换,比如之前是Dear,1现在就是2,Dear。在做Reduce的过程中还增加了一个不仅要分区还要排序根据key进行排序,这时候的key就是之前的value。最后,sorter工作,现在sorter的工作就减少了,因为之前已经对键值对进行了排序,现在sorter要将key和value的值交换。进行双排序之后写入Sink。

Source就是hdfs的文件,经过map,tokenizer顶点相当于map,做完map就可以输出单词加上1,这样的keyvalue键值对。然后对键值对求和,因为这里的求和之后需要排序,所以求和的过程不像MapReduce直接做Reduce,Reduce之后将value和key进行交换,比如之前是Dear,1现在就是2,Dear。在做Reduce的过程中还增加了一个不仅要分区还要排序根据key进行排序,这时候的key就是之前的value。最后,sorter工作,现在sorter的工作就减少了,因为之前已经对键值对进行了排序,现在sorter要将key和value的值交换。进行双排序之后写入Sink。

代码解释

dataSource来源于输入input,dataSink是输出的类型以及输出的位置。

定义tokenizerVertex顶点,ProcessorDescriptor定义相关的处理方法,这个处理方法是TokenProcessor,做的还是MapReduce。

创建编summationEdgeConf,是给下一个求和的顶点,顶点先要OrderedPartitionedKVEdgeConfig就是不仅要分区还要排序,这个编的输入类型就是key和value。

定义求和的顶点,求和的顶点由SumProcessor定义,SumProcessor类似于Reduce。

创建sorterEdgeConf编,和summationEdgeConf的功能类似,输入的类型是intkey,stringvalue,因为之前将key和value的值进行交换,连接的下一个顶点就是排序。

sorterVertex进行排序,因为之前做过排序,此处就不需要进行排序了。只是将key和value变换位置。

先获取conf,然后解析输入。

hadoopShim是兼容不同版本,针对不同的版本定义一系列的方法名,这些方法名有可能在不同的版本中对应的名称或者参数的名称可能会不一样。

创建tezConf和TezClient,需要见dag程序提交给applicationmaster,提交之后就可以做runJob。

操作

下载程序

1、在app-11上,以hadoop登录集群。

命令:su – hadoop

2、进入tmp目录下。

命令:cd /tmp/

3、创建tez-example文件。

命令:mkdir tez-example

4、进入Spark-stack/Tez/tezExamples/src/main/java/目录下。

命令:cd Spark-stack/Tez/tezExamples/src/main/java/

5、将org.tar拷贝到tez-example目录下。

命令:cp org.tar /tmp/tez-example/

6、将脚本文件也拷贝到tez-example目录下。先进入脚本文件目录下。

命令:cd /tmp/Spark-stack/Tez/tezExamples/src/resource/

7、将脚本文件也拷贝到tez-example目录下。

命令:cp buildExamples.sh /tmp/tez-example/

8、进入tez-example目录下。

命令:cd /tmp/tez-example/

运行

9、给脚本执行权限。

命令:chmod a+x buildExamples.sh

10、运行打包和提交的工作。

命令:./buildExamples.sh run

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Hive是什么

Hive是大数据仓库的基本组件。右侧是用java写的MapReduce的Wordcount例子,使用SQL语句去实现数据的查询、数据的分析。左侧是SQL语句实现Wordcount,首先将每一行切开根据每一个单词Space,从file中hdfs文件,然后根据Word进行排列,这都是map形式,最后再计算每个Word的总量,根据Word进行Order。下方是将上方的语句分解为两个部分,将子查询单独开来,门槛较低,不用写java程序,也不需要调试。

Hive是大数据仓库的基本组件。右侧是用java写的MapReduce的Wordcount例子,使用SQL语句去实现数据的查询、数据的分析。左侧是SQL语句实现Wordcount,首先将每一行切开根据每一个单词Space,从file中hdfs文件,然后根据Word进行排列,这都是map形式,最后再计算每个Word的总量,根据Word进行Order。下方是将上方的语句分解为两个部分,将子查询单独开来,门槛较低,不用写java程序,也不需要调试。

这幅图是Wordcount的Python版本。左侧是Python的map和reduce。右侧是SQL语句实现。相对于SQL语句,Python也是复杂的。 所以说,用SQL语句作为大数据查询分析的语言,可以有效合理而且直观的组织和使用数据模型,以降低数据分析的门槛,这就是Hive能够发展起来的一个动力。但是,这并不说明其他语言的编程接口没有价值,它们所解决的层次是不一样的。在其他的数据处理框架,比如说,Spark、Flink都有对应的SQL语句相关的一些接口。SQL语句不仅仅可以在做批处理上用还可以进入动态表理论、流上使用SQL。并说明,不是其他语言做大数据处理没有价值,将会被SQL淘汰,因为解决问题的层次是不一样的,有一些问题,仍然需要java、Python这种表现力更丰富的语言去做处理。这些框架使用的语言任然是底层语言java语言来编写的,或者理解为用高级语言编写的数据处理效率会更高而且相应的框架会对原生的语言(java语言)支持或者融合度会更好。

Hive基本架构

Hive包括了三个部分,Hive的客户端、Hive的服务器、数据。Hive的客户端有三类,Thrift、JDBC、ODBC,通过客户端连接服务器,服务器经过一系列的Driver将查询驱动数据仓库,数据仓库是文件。Hive合作的事情是将在HDFS文件,一个个文件抽象成结构化数据的结构,然后用SQL语句去查询分析这些文件的内容。比如说做MapReduce,Hive的服务器将对应的查询SQL语言转化为一系列的MapReduce或者Tez以docker的形式提交给集群比如YARN集群去执行我们相应的数据处理程序。除了Hive Server之外,还可以通过Hive services提供的客户端,或者Web界面的形式去操作SQL语句。体系架构里面有个Metastore,是因为Hive上存的都是一个个文件,文件里是一行行数据或者一行行的记录。为了执行SQL语句,必须要了解数据的各式信息,所谓的元数据信息,这就是Metastore存的基本信息,它不存数据,数据存在HDFS里,Metastore存在关系型数据库里。

Hive包括了三个部分,Hive的客户端、Hive的服务器、数据。Hive的客户端有三类,Thrift、JDBC、ODBC,通过客户端连接服务器,服务器经过一系列的Driver将查询驱动数据仓库,数据仓库是文件。Hive合作的事情是将在HDFS文件,一个个文件抽象成结构化数据的结构,然后用SQL语句去查询分析这些文件的内容。比如说做MapReduce,Hive的服务器将对应的查询SQL语言转化为一系列的MapReduce或者Tez以docker的形式提交给集群比如YARN集群去执行我们相应的数据处理程序。除了Hive Server之外,还可以通过Hive services提供的客户端,或者Web界面的形式去操作SQL语句。体系架构里面有个Metastore,是因为Hive上存的都是一个个文件,文件里是一行行数据或者一行行的记录。为了执行SQL语句,必须要了解数据的各式信息,所谓的元数据信息,这就是Metastore存的基本信息,它不存数据,数据存在HDFS里,Metastore存在关系型数据库里。

这是详细分析Metastore,可以有多个Metastore后端,MySQL是比较常用的,在Hive中提供了内置的Metastore,还有本地的方式也就是将MySQL部署在Hive Services所在的JVM的机器上,还支持远程的JVM去访问MySQL。将采用第三种方式,Hive Service不和MySQL在同一台机器上的部署方式。 Hive可以是计算引擎,唯一接触到数据的地方就是Metastore,存储的也仅仅是元数据,所有带分析的数据都存在的HDFS里面,由HDFS保证数据安全一致性。

和传统数据对比

Hive并不存储数据,仅仅存储元数据信息,数据都是以源文件的形式存储到HDFS中。在关系数据库中如果数据、描述丢失将很难恢复,但是在Hive中,HDFS数据没有丢失,Metastore丢失可以通过数据去恢复Metastore相对容易。 在传统的数据库中,表的模式是在数据加载时强制制定的。如果在加载时,发现数据不符合模式,加载肯定失败。Hive在查询时进行模式检查,在查询的时候才检查要查询的文件在元数据里面是否匹配,可以绕过Hive写入HDFS。这两种方法各有利弊,在Hive中是进入HDFS的,可以进行大数据量的。而传统的关系型数据库很难做到这一点。 性能不一样,Hive数据模式加载时非常快的,因为不需要检查数据格式信息,直接写到HDFS中。在传统数据中写入需要一条条的检查,但是有另一种优势,查询性能是非常高的,因为可以进行数据的索引。 传统型数据库是做事务处理的,Hive在做事务处理方面就不如传统数据库。Hive不支持更新、删除等。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Hive是什么

Hive是大数据仓库的基本组件。右侧是用java写的MapReduce的Wordcount例子,使用SQL语句去实现数据的查询、数据的分析。左侧是SQL语句实现Wordcount,首先将每一行切开根据每一个单词Space,从file中hdfs文件,然后根据Word进行排列,这都是map形式,最后再计算每个Word的总量,根据Word进行Order。下方是将上方的语句分解为两个部分,将子查询单独开来,门槛较低,不用写java程序,也不需要调试。

Hive是大数据仓库的基本组件。右侧是用java写的MapReduce的Wordcount例子,使用SQL语句去实现数据的查询、数据的分析。左侧是SQL语句实现Wordcount,首先将每一行切开根据每一个单词Space,从file中hdfs文件,然后根据Word进行排列,这都是map形式,最后再计算每个Word的总量,根据Word进行Order。下方是将上方的语句分解为两个部分,将子查询单独开来,门槛较低,不用写java程序,也不需要调试。

这幅图是Wordcount的Python版本。左侧是Python的map和reduce。右侧是SQL语句实现。相对于SQL语句,Python也是复杂的。 所以说,用SQL语句作为大数据查询分析的语言,可以有效合理而且直观的组织和使用数据模型,以降低数据分析的门槛,这就是Hive能够发展起来的一个动力。但是,这并不说明其他语言的编程接口没有价值,它们所解决的层次是不一样的。在其他的数据处理框架,比如说,Spark、Flink都有对应的SQL语句相关的一些接口。SQL语句不仅仅可以在做批处理上用还可以进入动态表理论、流上使用SQL。并说明,不是其他语言做大数据处理没有价值,将会被SQL淘汰,因为解决问题的层次是不一样的,有一些问题,仍然需要java、Python这种表现力更丰富的语言去做处理。这些框架使用的语言任然是底层语言java语言来编写的,或者理解为用高级语言编写的数据处理效率会更高而且相应的框架会对原生的语言(java语言)支持或者融合度会更好。

Hive基本架构

Hive包括了三个部分,Hive的客户端、Hive的服务器、数据。Hive的客户端有三类,Thrift、JDBC、ODBC,通过客户端连接服务器,服务器经过一系列的Driver将查询驱动数据仓库,数据仓库是文件。Hive合作的事情是将在HDFS文件,一个个文件抽象成结构化数据的结构,然后用SQL语句去查询分析这些文件的内容。比如说做MapReduce,Hive的服务器将对应的查询SQL语言转化为一系列的MapReduce或者Tez以docker的形式提交给集群比如YARN集群去执行我们相应的数据处理程序。除了Hive Server之外,还可以通过Hive services提供的客户端,或者Web界面的形式去操作SQL语句。体系架构里面有个Metastore,是因为Hive上存的都是一个个文件,文件里是一行行数据或者一行行的记录。为了执行SQL语句,必须要了解数据的各式信息,所谓的元数据信息,这就是Metastore存的基本信息,它不存数据,数据存在HDFS里,Metastore存在关系型数据库里。

Hive包括了三个部分,Hive的客户端、Hive的服务器、数据。Hive的客户端有三类,Thrift、JDBC、ODBC,通过客户端连接服务器,服务器经过一系列的Driver将查询驱动数据仓库,数据仓库是文件。Hive合作的事情是将在HDFS文件,一个个文件抽象成结构化数据的结构,然后用SQL语句去查询分析这些文件的内容。比如说做MapReduce,Hive的服务器将对应的查询SQL语言转化为一系列的MapReduce或者Tez以docker的形式提交给集群比如YARN集群去执行我们相应的数据处理程序。除了Hive Server之外,还可以通过Hive services提供的客户端,或者Web界面的形式去操作SQL语句。体系架构里面有个Metastore,是因为Hive上存的都是一个个文件,文件里是一行行数据或者一行行的记录。为了执行SQL语句,必须要了解数据的各式信息,所谓的元数据信息,这就是Metastore存的基本信息,它不存数据,数据存在HDFS里,Metastore存在关系型数据库里。

这是详细分析Metastore,可以有多个Metastore后端,MySQL是比较常用的,在Hive中提供了内置的Metastore,还有本地的方式也就是将MySQL部署在Hive Services所在的JVM的机器上,还支持远程的JVM去访问MySQL。将采用第三种方式,Hive Service不和MySQL在同一台机器上的部署方式。 Hive可以是计算引擎,唯一接触到数据的地方就是Metastore,存储的也仅仅是元数据,所有带分析的数据都存在的HDFS里面,由HDFS保证数据安全一致性。

和传统数据对比

Hive并不存储数据,仅仅存储元数据信息,数据都是以源文件的形式存储到HDFS中。在关系数据库中如果数据、描述丢失将很难恢复,但是在Hive中,HDFS数据没有丢失,Metastore丢失可以通过数据去恢复Metastore相对容易。 在传统的数据库中,表的模式是在数据加载时强制制定的。如果在加载时,发现数据不符合模式,加载肯定失败。Hive在查询时进行模式检查,在查询的时候才检查要查询的文件在元数据里面是否匹配,可以绕过Hive写入HDFS。这两种方法各有利弊,在Hive中是进入HDFS的,可以进行大数据量的。而传统的关系型数据库很难做到这一点。 性能不一样,Hive数据模式加载时非常快的,因为不需要检查数据格式信息,直接写到HDFS中。在传统数据中写入需要一条条的检查,但是有另一种优势,查询性能是非常高的,因为可以进行数据的索引。 传统型数据库是做事务处理的,Hive在做事务处理方面就不如传统数据库。Hive不支持更新、删除等。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

修改模板配置文件解释

修改hive-default.xml.template

修改了两个目录的路径,将Hive的配置文件存在安装目录的tmp下,所以会创建一个tmp。将所有产生的临时文件或者配置文件,所有的工作内容都放到了安装目录下。

修改了两个目录的路径,将Hive的配置文件存在安装目录的tmp下,所以会创建一个tmp。将所有产生的临时文件或者配置文件,所有的工作内容都放到了安装目录下。

将metastore的路径更改到app-12上。

将metastore的路径更改到app-12上。

相关的连接密码修改为Yhf_1018。

相关的连接密码修改为Yhf_1018。

连接的字符串。

连接的字符串。

在初始化之后会创建schema,不需要检验。

在初始化之后会创建schema,不需要检验。

修改hive-log4j2.properties.template

将log的目录更改到安装目录下。

将log的目录更改到安装目录下。

启用自动化集群脚本

1、在app-11上,以hadoop用户登录。

命令:su - hadoop

2、进入到/hadoop目录下。

命令:cd /hadoop/

3、将config.conf、startAll.sh、stopAll.sh删除。

命令:rm -rf config.conf startAll.sh stopAll.sh

4、进入/tmp/Spark-stack/Hive/Automated scripts/目录下。

命令:cd /tmp/Spark-stack/Hive/Automated scripts/

5、将 startAll.sh、stopAll.sh、config.conf /hadoop/拷贝到/hadoop目录下。

命令:cp -r startAll.sh stopAll.sh config.conf /hadoop/

6、将cremoteSSH.exp 拷贝到/hadoop/tools/目录下。

命令:cp remoteSSH.exp /hadoop/tools/

7、进入/hadoop目录下。

命令:cd /hadoop/

8、赋予执行权限。

命令:chmod a+x *.sh

9、启动集群。

命令:./startAll.sh

安装Hive

将Hive安装到app-12上,减轻app-11的负载。

检查集群是否正常启动

1、在app-11上,以hadoop登录。

命令:su – hadoop注:所有的启停工作都在app-11上。

2、检查集群是否正常启动。

命令:jps

检查3306端口(MySQL端口)是否启动

3、在app-12上。

命令:netstat -tnl注:如果没有启动需要手动启动。

启动MySQL

4、在app-12的hadoopmysql中new terminal。

5、进入root用户下。

命令:sudo /bin/bash

6、启动mysql服务器。

命令:service mysql start

7、登录MySQL,查看是否正常启动。

命令:mysql -uroot -p 注:输入数据库密码,这里的默认密码是Yhf_1018。

下载安装包

8、在app-12上hadoopc2的new terminal,以hadoop用户登录。

命令:su – hadoop注:所有的启停工作都在app-11上。

9、进入hadoop目录下。

命令:cd /hadoop/

10、创建安装Hive的目录。

命令:mkdir Hive

11、进入到该目录下。

命令:cd Hive/

12、下载Hive安装包。

命令:wget https://archive.apache.org/dist/hive/hive-3.1.1/apache-hive-3.1.1-bin.tar.gz

13、解压安装包。

命令:tar -xf apache-hive-3.1.1-bin.tar.gz

更改模板配置文件

14、进入到安装目录下的配置文件。

命令:cd apache-hive-3.1.1-bin/conf/

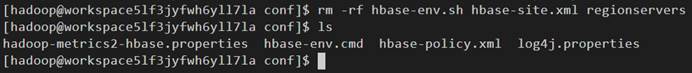

15、删除hive-default.xml.template和hive-log4j2.properties.template模板文件。

命令:rm -r hive-log4j2.properties.template hive-default.xml.template

16、进入到/tmp/Spark-stack/Hive/conf/目录下。

命令:cd /tmp/Spark-stack/Hive/conf/

17、将修改后的配置文件拷贝到安装目录下的配置文件中。

命令:cp -r hive-log4j2.properties hive-site.xml /hadoop/Hive/apache-hive-3.1.1-bin/conf/

修改环境变量

18、返回安装目录。

命令:cd /hadoop/Hive/apache-hive-3.1.1-bin

19、创建tmp和log文件。

命令:mkdir {tmp,log}

20、将Hive的路径加到环境变量中。

命令:vi ~/.bashrc

export HIVE_HOME=/hadoop/Hive/apache-hive-3.1.1-bin

export PATH=${HIVE_HOME}/bin:$PATH

21、将环境变量生效。

命令:source ~/.bashrc

22、查看环境变量是否生效。

命令:echo $PATH

创建Metastore的database

23、返回mysql中new terminal,赋权限在任何客户端都可以登录,不受ip限制。

命令:GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY 'Yhf_1018' with grant option;

24、将权限生效。

命令:FLUSH privileges;

25、先删除Metastore的database,这里是没有的,为了多次使用安全的一个措施。

命令:drop database if exists hive;

26、创建Metastore的database。

命令:create database hive;

27、查看是否创建成功。

命令:show databases;

28、退出MySQL。

命令:quit

下载驱动

29、返回hadoopc2的new terminal上,将MySQL的驱动下载到安装目录的lib下,先进入到lib的目录下。

命令:cd lib/

30、下载驱动。

命令:wget https://repo1.maven.org/maven2/mysql/mysql-connector-java/8.0.11/mysql-connector-java-8.0.11.jar

初始化Metastore

31、进入bin目录下。

命令:cd /hadoop/Hive/apache-hive-3.1.1-bin/bin

32、初始化Metastore。

命令:schematool -dbType mysql -initSchema

启动Hive service

33、启动Hive service。

命令:nohup ./hive --service metastore > /hadoop/Hive/apache-hive-3.1.1-bin/log/metastore.log 2>&1 &注:因为需要将service放到后台服务,所以使用nohup启动方式启动metastore服务,将所有的打印打印到log下

34、将hive进程显示出来。

命令:ps -ef | grep hive

35、启动hive。

命令:hive

36、查看databases。

命令:show databases;注:没有创建database。

37、按Ctrl+c退出命令行。

重启集群

38、在app-11上,进入/hadoop目录。

命令:cd /hadoop/

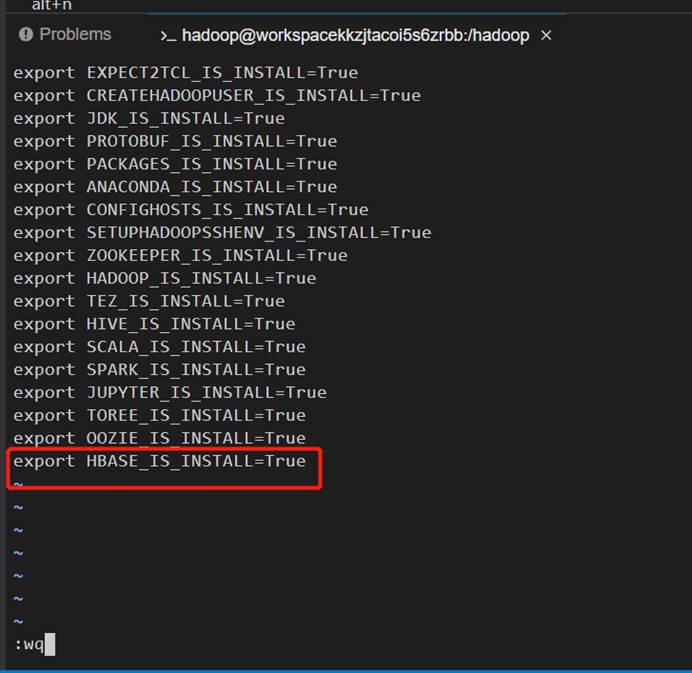

39、将安装完的信息export出去。

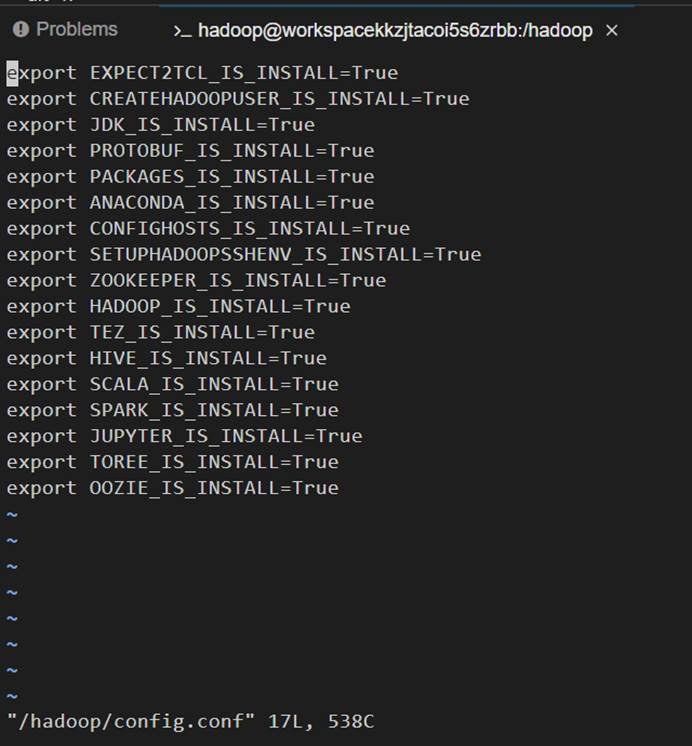

命令:vi config.conf

40、停止所有的集群。

命令:./stopAll.sh

41、登录其他两台机器查看集群。

命令:ssh hadoop@app-12 "jps"、ssh hadoop@app-13 "jps"

42、重启集群。

命令:./startAll.sh

43、查看集群启动。

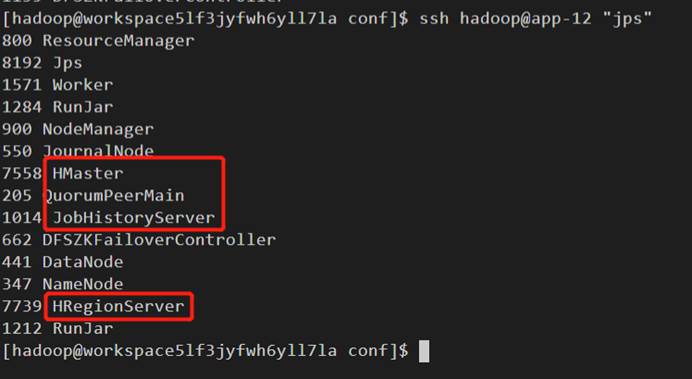

命令:jps

44、查看其它机器上的集群。

命令:ssh hadoop@app-12 "jps"、ssh hadoop@app-13 "jps"

常见问题

问题原因:在lib目录下初始化一系列工作了。 问题解决:删除集群重新搭建。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

检查集群是否正常

1、在app-11上,以hadoop用户登录。

命令:su – hadoop

2、进入/hadoop/目录下。

命令:cd /hadoop/

3、检查集群是否正常。

命令:jps

操作

1、在app-12上,以hadoop用户登录。

命令:su – hadoop

2、查看Hive支持哪些命令。

命令:hive --help

3、查看环境变量里的hadoop配置。

命令:echo $HADOOP_HOME

4、启动客户端。

命令:hive 注:功能比较弱。不支持删除、自动补传等功能。

5、按Ctrl+c,退出。

6、不启用hive查询databases。

命令:hive -e "show databases"

7、使用静默参数,将结果输入文件中。

命令:hive -S -e "show databases" > /tmp/hai.txt

8、查看输出文件结果。

命令:cat /tmp/hai.txt

9、进入hive。

命令:hive --service cli

10、查看databases。

命令:show databases;

11、查看hdfs目录。

命令:dfs -ls / ;

12、退出。

命令:quit;

模拟hive启动失败

1、先删除HADOOP_HOME。

命令:unset HADOOP_HOME

2、查看环境变量。

命令:echo $HADOOP_HOME 注:因为删除了,所有空了。

3、删除Hadoop环境变量。

命令:export PATH=/hadoop/Hive/apache-hive-3.1.1-bin/bin:/hadoop/JDK/jdk1.8.0_131/bin:/usr/local/bin:/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/home/hadoop/.local/bin:/home/hadoop/bin

4、启动hive客户端。

命令:hive --service cli 注:启动失败。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

HiveQL数据定义

1、在app-12上,以hadoop用户登录。

命令:su – hadoop

2、启动hive。

命令:hive --service cli

3、查看databases。

命令:show databases;

手动创建databases

4、创建test。

命令:CREATE DATABASE IF NOT EXISTS test;

5、查看是否创建成功。

命令:show databases;

6、进入test。

命令:use test;

7、创建employee表。

命令:CREATE TABLE IF NOT EXISTS `EMPLOYEE` ( `ID` bigint, `NAME` string, CONSTRAINT `SYS_PK_BUCKETING_COLS` PRIMARY KEY (`ID`) DISABLE ) ROW FORMAT DELIMITED FIELDS TERMINATED BY '|' ;

注:``这个符号为标识符,数据名字。

下载数据

8、新建new terminal,以hadoop用户登录。

命令:su – hadoop

9、进入/tmp目录下。

命令:cd /tmp/

10、创建hive文件。

命令:mkdir hive

11、进入 /tmp/Spark-stack/Hive/HiveQL/目录下。

命令:cd /tmp/Spark-stack/Hive/HiveQL/

12、将employee.dat 拷贝到/tmp/hive/目录下。

命令:cp employee.dat /tmp/hive/

8、返回之前的new terminal,加载数据到table中。

命令:LOAD DATA LOCAL INPATH '/tmp/hive/employee.dat' OVERWRITE INTO TABLE EMPLOYEE;

9、查询数据。

命令:select * from EMPLOYEE;

数据库与hdfs对应关系

观察创建完表和数据库之后,在HDFS上有什么变化

1、在app-11上,以hadoop用户登录。

命令:su – hadoop

2、配置文件默认的数据存储仓库在hive/warehouse/

命令:hdfs dfs -ls /user/hive/warehouse/

3、查看test.db文件

命令:hdfs dfs -ls /user/hive/warehouse/test.db

4、查看employee表。

命令:hdfs dfs -ls /user/hive/warehouse/test.db/employee

5、查看employee.dat数据集内容。

命令:hdfs dfs -cat /user/hive/warehouse/test.db/employee/employee.dat

内部表和外部表操作与hdfs文件管控

1、将数据拷贝到/installTest目录下。

命令:hdfs dfs -cp /user/hive/warehouse/test.db/employee/employee.dat /installTest

2、返回app-12的命令行,删除表。

命令:drop table employee;

3、返回app-11上,再次查看。

命令:hdfs dfs -ls /user/hive/warehouse/test.db注:数据已经删除了,但是test.db没有删除掉。

4、返回app-12上,删除test.db。

命令:drop database test;

5、返回app-11上,查看是否删除。

命令:hdfs dfs -ls /user/hive/warehouse/test.db注:已经删除,数据库已经被删除。

创建外部表

6、创建一个空目录存放数据。

命令:hdfs dfs -mkdir /installTest/hive

7、将拷贝过来的employee.dat拷贝到hive目录下。

命令:hdfs dfs -cp /installTest/employee.dat /installTest/hive

8、返回app-12上,创建表,先创建database。

命令:CREATE DATABASE IF NOT EXISTS test;

9、进入test。

命令:use test;

10、创建表。

命令:CREATE TABLE IF NOT EXISTS `EMPLOYEE` ( `ID` bigint, `NAME` string, CONSTRAINT `SYS_PK_BUCKETING_COLS` PRIMARY KEY (`ID`) DISABLE ) ROW FORMAT DELIMITED FIELDS TERMINATED BY '|' LOCATION '/installTest/hive';

注:外部表创建成功。

11、做一次查询。

命令:select * from EMPLOYEE; 注:内部表和外部表在其他操作上是一致的。

HiveQL查询

12、在app-12上退出命令行环境。

命令:quit;

13、进入tmp目录下。

命令:cd /tmp/

14、将hive文件删除重新创建存放临时数据。

命令:rm -rf hive/、mkdir hive

15、进入Spark-stack/Hive/目录下。

命令:cd Spark-stack/Hive/

16、将HiveQL目录下的文件拷贝到/tmp/hive/目录下。

命令:cp -rf HiveQL/* /tmp/hive/

17、进入/tmp/hive/目录下。

命令:cd /tmp/hive/

18、查看employee.sql脚本

命令:vi employee.sql 注:这是创建外部表的脚本。

19、加载脚本。

命令:hive -f /tmp/hive/employee.sql

20、切换到命令行环境。

命令:hive --service cli

21、进入test。

命令:use test;

22、设置MapReduce的Map memory和reduce memory为2G。

命令:set mapreduce.map.memory.mb=2048;、set mapreduce.reduce.memory.mb=2048;

23、查询。

命令:select count(*) from employee; 注:时间是4.38秒。

24、查询现在的执行引擎。

命令:set hive.execution.engine;

25、将执行引擎改为mr。

命令:set hive.execution.engine=mr;

26、再一次查询。

命令:select count(*) from employee;注:时间是10.55秒。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

1、在app-12上,用hadoop用户登录。

命令:su - hadoop

2、登录命令行。

命令:hive --service cli

3、进入test库。

命令:use test;

4、给employee上锁,并且是排他。

命令:lock table employee exclusive;

5、新建new terminal,进入zookeeper客户端。

命令:su – hadoop、zkCli.sh

6、查看zookeeper发生什么变化。

命令:ls /注:增加了hive_zookeeper_namespace节点。

7、查看hive_zookeeper_namespace节点。

命令:ls /hive_zookeeper_namespace

8、查看test节点。

命令:ls /hive_zookeeper_namespace/test

9、查看employee表。

命令:ls /hive_zookeeper_namespace/test/employee 注:生成了一个排他锁。

10、返回命令行,删除锁。

命令:unlock table employee;

11、在回到zookeeper查看表。

命令:ls /hive_zookeeper_namespace/test/employee注:已经不存在了。

12、返回命令行,对表再次上锁。

命令:lock table employee exclusive;

13、返回zookeeper,退出客户端。

命令:quit

14、登录hive命令行。

命令:hive --service cli

15、进入test。

命令:use test;

16、做查询。

命令:select * from employee; 注:光标一直在闪。

17、返回命令行,删除锁。

命令:unlock table employee;

18、返回,做查询。

命令:select * from employee; 注:光标还是在闪。

19、退出命令行,重新查询。

命令:按Ctrl+c、hive -e "use test;select * from employee"

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

深入理解Hive视频教程1

深入理解Hive视频教程2

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Spark是什么

Spark是数据处理引擎,Hadoop的YARN是集群管理的组件,HDFS是数据存储的组件,MapReduce是数据处理的引擎。通常一套大数据解决方案包括了很多组件,有存储、计算、MapReduce、Spark等等。Spark做数据处理引擎,可以说是给你一个计算平台,承担上面的计算任务或者算法,由自己提供的,而在数据处理框架之上是需要一套分析软件,那么这套分析软件是根据业务特点去编程的。Spark是生态系统,Spark有数据处理引擎,同时在引擎之上做流处理,应用范围越来越广。Spark的突出特点是使用了内存运算和基于docker、基于计算图的方式去表述应用。

Spark是大一统的数据处理引擎

这幅图展示了Spark包括了的组件。Spark进入SQL,Datasets,DataFrames提供了结构化分析手段。Structured Streaming是处理流数据,关系型的查询就用SQL去处理流式数据。这两个包括了现在数据处理引擎的两个重要特点,第一个特点是处理结构化数据,将数据抽象成结构化数据。第二个特点是Structured流处理方式,流处理是实时大数据的一个核心理论。RDD是Spark发展初期一个重要的概念,弹性的数据集,进入这种数据集去构架Spark引擎,即将被其他的API所替代,比如Spark SQL,因为Spark SQL可以获得更高的性能。Spark Streaming也是Spark初期流处理的API框架,但是随着流处理理论的发展,这种API已经不适合现在流处理的发展了,Structured Streaming代替了Spark Streaming。MLlib是机器学习和GraphX是处理图。这些涵盖了大数据引擎的基本结构,批处理、流处理和图处理就是Spark是大一统的数据处理引擎的核心。

为什么不选择RDD

RDD是核心的但是是老的API,Flink的核心框架就是Datasets和DataFrames,所有的数据抽象成一个集合或者一个流。RDD这种弹性的数据集不能让使用者更理解内部机制或者更好的使用这个软件。所以说Spark选择将隐藏起来,而推出做流处理和批处理相应API的重要原因。无法判断是Flink学习了Spark还是Spark学习了Flink,我们得不出这个结论,但是,从现在大数据发展的理论上看,Dataset和DataStream这两种抽象是我们分析引擎的核心主流思想,都需要向着两个思想去融合,Spark也做到了这一点,这是为什么不选择RDD作为Spark主要API提供给用户的原因。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Spark是什么

Spark是数据处理引擎,Hadoop的YARN是集群管理的组件,HDFS是数据存储的组件,MapReduce是数据处理的引擎。通常一套大数据解决方案包括了很多组件,有存储、计算、MapReduce、Spark等等。Spark做数据处理引擎,可以说是给你一个计算平台,承担上面的计算任务或者算法,由自己提供的,而在数据处理框架之上是需要一套分析软件,那么这套分析软件是根据业务特点去编程的。Spark是生态系统,Spark有数据处理引擎,同时在引擎之上做流处理,应用范围越来越广。Spark的突出特点是使用了内存运算和基于docker、基于计算图的方式去表述应用。

Spark是大一统的数据处理引擎

这幅图展示了Spark包括了的组件。Spark进入SQL,Datasets,DataFrames提供了结构化分析手段。Structured Streaming是处理流数据,关系型的查询就用SQL去处理流式数据。这两个包括了现在数据处理引擎的两个重要特点,第一个特点是处理结构化数据,将数据抽象成结构化数据。第二个特点是Structured流处理方式,流处理是实时大数据的一个核心理论。RDD是Spark发展初期一个重要的概念,弹性的数据集,进入这种数据集去构架Spark引擎,即将被其他的API所替代,比如Spark SQL,因为Spark SQL可以获得更高的性能。Spark Streaming也是Spark初期流处理的API框架,但是随着流处理理论的发展,这种API已经不适合现在流处理的发展了,Structured Streaming代替了Spark Streaming。MLlib是机器学习和GraphX是处理图。这些涵盖了大数据引擎的基本结构,批处理、流处理和图处理就是Spark是大一统的数据处理引擎的核心。

为什么不选择RDD

RDD是核心的但是是老的API,Flink的核心框架就是Datasets和DataFrames,所有的数据抽象成一个集合或者一个流。RDD这种弹性的数据集不能让使用者更理解内部机制或者更好的使用这个软件。所以说Spark选择将隐藏起来,而推出做流处理和批处理相应API的重要原因。无法判断是Flink学习了Spark还是Spark学习了Flink,我们得不出这个结论,但是,从现在大数据发展的理论上看,Dataset和DataStream这两种抽象是我们分析引擎的核心主流思想,都需要向着两个思想去融合,Spark也做到了这一点,这是为什么不选择RDD作为Spark主要API提供给用户的原因。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Spark编程模型与基本框架视频教程1

Spark编程模型与基本框架视频教程2

Spark编程模型与Spark基本架构

在程序上创建Spark Context,在上下文定义一系列的数据处理函数,加载数据的处理方式。在客户端有个Driver Application,调度编译程序执行,包括ActorSystem、Block Manager、BroadcastManager、TaskSchedule、DAGScheduler。用户通过SparkContext提供的API进行编写程序,会首先使用Block Manager和BroadcastManager将任务进行广播,广播的是任务的配置信息。然后由DAGScheduler将一个应用当成job,一个job有一个DAG组成,然后由ActorSystem去提交DAG给集群运行,然后,集群的管理器分配资源。Worker里面有个执行器,由执行器去执行任务。TaskScheduler调度Worker去执行。比如说MapReduce,被分解成一个个的Task,每个Task运行在某个容器上,Cluster Manager通过TaskScheduler执行Executor程序。

Spark基本框架

有很多个Driver因为要提交很多的app,客户端可以有多用户系统,客户端可以向Cluster Manager去提交任务,我们的任务不一定运行在Standalone端,可以在YARN、Mesos、EC2端,然后由Cluster Manager调度Executor去执行程序。

SparkContext

第一个是Python定义的Spark Context形式,第二个是Scala定义的,最后一个是java定义的,他们的定义形式是一样的,表现形式是不一样的。先设置一个conf在新建一个context。

任务调度

任务调度分为两部分,DAGScheduler和TaskScheduler。DAGScheduler负责将图划分为各个阶段,提交每个阶段。Spark底层仍然借助了MapReduce形式,因为在做大数据处理,Map和Reduce的思想目前还是无法超越的,ADG是有流程的。将TaskSet提交给TaskScheduler,和Cluster manager交互,TaskLaunch去申请Worker容器,容器里有执行器去执行每个任务,最后,将结果按照一定的各式存储。

部署模式

Spark的部署模式有多种,有Standalone,也就是自己有一个master,在我们的集群里,app-13是master,app-12和app-11是worker组成了一个主从的集群。

计算引擎

Tez是用Map和Reduce做逻辑的形式,然后做join,底层的机制仍然是MapReduce。Hive也是MapReduce,右边是通过解析执行计划,得到结果,仍然是进入MapReduce。因为Hive的底层是Tez,Tez也是通过MapReduce的。

Spark也是一样的,将userData和joined相当于是做Map,events相当于是reduce,在events中拉取数据。MapReduce目前来说是大数据最核心的、有力的思想,还没有过时。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

编译

编译的时候只创建一个机器即可,启动app-11,在编译的时候会占用大量的资源。

1、以hadoop用户登录。

命令:su – hadoop

2、切换到tmp根目录下。

命令:cd /tmp/

3、创建编译spark目录。

命令:mkdir spark

4、创建Maven仓库。

命令:mkdir -p /home/hadoop/.m2/repository/org/spark-project

5、进入spark目录下。

命令:cd spark/

6、下载编译安装包。

命令:wget https://archive.apache.org/dist/spark/spark-2.4.0/spark-2.4.0.tgz

7、解压。

命令:tar -xf spark-2.4.0.tgz

8、进入spark-2.4.0目录。

命令:cd spark-2.4.0

9、删除pom.xml文件。

命令:rm -rf pom.xml

10、切换到Spark的编译目录下。

命令:cd /tmp/Spark-stack/Spark/compile/

11、将pom_hive3.xml拷贝到spark解压之后的目录下。

命令:cp pom_hive3.xml /tmp/spark/spark-2.4.0

12、将spark-project.zip解压到Maven库中。

命令:unzip /tmp/Spark-stack/Spark/compile/spark-project.zip -d /home/hadoop/.m2/repository/org/spark-project/

13、进入到spark安装目录下。

命令:cd /tmp/spark/spark-2.4.0

14、将pom_hive3.xml改名为pom.xml。

命令:mv pom_hive3.xml pom.xml

15、设置Maven的OPTS使用内存的设置。

命令:export MAVEN_OPTS="-Xmx3g -XX:ReservedCodeCacheSize=512m"

16、开始编译。

命令:./dev/make-distribution.sh --name hadoop3.1.2 --tgz -Phadoop-3.1 -Dhadoop.version=3.1.2 -Phive -Dhive.version=1.21.2.3.1.2.0-4 -Dhive.version.short=1.21.2.3.1.2.0-4 -Phive-thriftserver -Pyarn

注:时间会很长。

安装Spark

再创建另外两台机器,确保三台机器正常运行。

下载安装包

1、在app-11上进行三台机器的认证。

命令:sudo /bin/bash、cd /hadoop、 ./initHosts.sh

2、启动集群。

命令:su – hadoop、cd /hadoop/、./startAll.sh

3、检查启动集群。

命令:jps

4、创建安装Spark的目录。

命令:mkdir Spark

5、进入到编译之后的目录下。

命令:cd /tmp/spark/spark-2.4.0

6、将spark的安装包拷贝到Spark的安装目录下。

命令:cp spark-2.4.0-bin-hadoop3.1.2.tgz /hadoop/Spark/

7、进入到Spark安装目录下。

命令:cd /hadoop/Spark/

8、解压安装包。

命令:tar -xf spark-2.4.0-bin-hadoop3.1.2.tgz

9、进入Spark目录,下载配置文件。

命令:cd /tmp/Spark-stack/Spark/

10、拷贝基本配置文件。

命令:cp Bconf/* /hadoop/Spark/

11、返回Spark的安装目录下。

命令:cd /hadoop/Spark/

修改配置文件

12、进入解压之后的目录下。

命令:cd spark-2.4.0-bin-hadoop3.1.2

13、进入配置文件下。

命令:cd conf/

14、将下载下来的slaves文件拷贝到该目录下。

命令:cp /hadoop/Spark/slaves ./

15、将下载下来的spark-env.sh文件拷贝到该目录下。

命令:cp /hadoop/Spark/spark-env.sh ./

安装Scala

16、切到Spark的安装目录下。

命令:cd /hadoop/Spark/

17、下载Scala安装包。

命令:wget https://downloads.lightbend.com/scala/2.11.12/scala-2.11.12.tgz

18、返回hadoop目录。

命令:cd /hadoop/

19、创建安装Scala目录。

命令:mkdir Scala

20、将下载的Scala安装包拷贝到Scala目录下。

命令:tar -xf Spark/scala-2.11.12.tgz -C Scala/

21、给Scala赋予执行权限。

命令:chmod -R a+x /hadoop/Scala/scala-2.11.12/

修改环境变量

22、修改环境变量。

命令:vi ~/.bashrc

export SPARK_HOME=/hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2

export PATH=${SPARK_HOME}/bin:$PATH

export SCALA_HOME=/hadoop/Scala/scala-2.11.12

export PATH=${SCALA_HOME}/bin:$PATH

23、环境变量生效。

命令:source ~/.bashrc

24、检查环境变量生效。

命令:echo $PATH

清理工作

25、进入Spark安装目录下。

命令:cd Spark/

26、删除没用的文件。

命令:rm -rf scala-2.11.12.tgz slaves spark-2.4.0-bin-hadoop3.1.2.tgz spark-env.sh

27、将config.conf拷贝到hadoop的根目录下。

命令:mv config.conf /hadoop/

拷贝到集群的其他机器上

28、切换到hadoop的根目录下。

命令:cd /hadoop/

29、将环境变量拷贝到其他机器上。

命令:scp ~/.bashrc hadoop@app-12:/hadoop/

scp ~/.bashrc hadoop@app-13:/hadoop/

30、将Spark静默拷贝到其他机器上。

命令:for name in app-12 app-13; do scp -r -q Spark $name:/hadoop/; done

31、将Scala拷贝到其他机器上。

命令:for name in app-12 app-13; do scp -r -q Scala $name:/hadoop/; done

启动集群

32、进入Spark的安装目录下。

命令:cd /hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/

33、启动集群。

命令:sbin/start-all.sh

34、检查集群。

命令:jps

注:Worker集群已经启动了。

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Spark集群模式

Spark集群模式Standalone,之前安装的配置模式就是Standalone,自己有集群,有一个master和三个work。这种集群是没有做HA的,因为想做HA可以集群的管理框架。

例子-Pyspark

1、以hadoop用户登录。

命令:su – hadoop

2、进入Spark的安装目录下。

命令:cd /hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/

3、进入Python环境。

命令:bin/pyspark

4、查询。

命令:

from os.path import expanduser, join, abspath

from pyspark.sql import SparkSession

from pyspark.sql import Row

warehouse_location = abspath('/user/hive/warehouse')

spark = SparkSession.builder.appName("Python Spark SQL Hive integration example").config("spark.sql.warehouse.dir",warehouse_location).enableHiveSupport().getOrCreate()

spark.sql("SELECT * FROM test.employee").show()

注:查询失败,需要将hive的配置文件拷贝到Spark配置目录下。

5、退出命令行。

命令:quit()

6、进入到Spark的配置目录下。

命令:cd /hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/conf/

7、将hive的配置文件拷贝到Spark配置目录下。

命令:scp app-12:/hadoop/Hive/apache-hive-3.1.1-bin/conf/hive-site.xml ./

8、将hive-site.xml拷贝到app-13上。

命令:scp hive-site.xml app-13:/hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/conf/

9、切换到spark的根目录下。

命令:cd /hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/

10、运行pyspark。

命令:bin/pyspark

11、select查询。

命令:spark = SparkSession.builder.appName("Python Spark SQL Hive integration example").config("spark.sql.warehouse.dir",warehouse_location).enableHiveSupport().getOrCreate()

spark.sql("SELECT * FROM test.employee").show()

12、count查询。

命令:spark.sql("SELECT COUNT(*) FROM test.employee").show()

13、退出命令行。

命令:quit()

Python脚本通过spark-submit提交yarn集群

如果没有做Pyspark例子,可以参考例子将hive的配置文件拷贝到整个集群的Spark配置目录下。

1、进入到Spark例子目录下。

命令:cd /tmp/Spark-stack/Spark/case/

2、将SparkHiveExample.py程序拷贝到Spark安装目录下。

命令:cp SparkHiveExample.py /hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/

3、进入spark的安装目录下。

命令:cd /hadoop/Spark/spark-2.4.0-bin-hadoop3.1.2/

4、将程序提交给yarn集群。

命令:./bin/spark-submit SparkHiveExample.py --master yarn --deploy-mode cluster --driver-memory 2g --executor-memory 1g --executor-cores 1 --queuedefault

Python-Scala版本

如果没有做Pyspark例子,可以参考例子将hive的配置文件拷贝到整个集群的Spark配置目录下。

1、进入命令行。

命令:bin/spark-shell

注:默认进入Scala编译环境。

2、交互性执行。

命令:

import java.io.File

import org.apache.spark.sql.{Row, SaveMode, SparkSession}

val warehouseLocation = new File("/user/hive/warehouse").getAbsolutePath

val spark = SparkSession.builder().appName("Spark Hive

Example").config("spark.sql.warehouse.dir",warehouseLocation).enableHiveSupport().getOrCreate()

import spark.implicits._

import spark.sql

3、select查询。

命令:sql("SELECT * FROM test.employee").show()

4、count查询。

命令:sql("SELECT COUNT(*) FROM test.employee").show()

5、停止spark。

命令:spark.stop()

6、退出命令行。

命令::quit

Spark-sql版本

如果没有做Pyspark例子,可以参考例子将hive的配置文件拷贝到整个集群的Spark配置目录下。

1、进入命令行。

命令:bin/spark-sql

2、查看databases。

命令:show databases;

3、进入test。

命令:use test;

4、查看tables。

命令:show tables;

5、select查询。

命令:select * from employee;

6、退出命令行。

命令:quit;

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Oozie是解决工作流,特别是大数据处理工作流的任务框架。

工作流的必要性

第一点是在大数据处理中需要创建端到端的应用,经常处理一些定时、调度、shell脚本将流程化的节点串接在一起,如果使用传统的方式也就是脚本,但是效率比较底下,无法可视化的对脚本处理,以及相应的脚本的错误处理、通知、其他的监控通知无法做到自动化,而且不同的步骤之间的逻辑以及精细化的调度也很难做精细化的处理。所以说,我们需要在大数据工作流引擎,去支撑这种应用。 第二点如果自己做一些Spark脚本,需要通过一系列的提交,这个工作效率是非常低的。之所以为什么不模拟Spark客户端去提交信息,是因为数据处理任务仅仅是写一个处理函数,相关的步骤框架是通过Oozie满足的。这也是大数据工作引入的必须的条件。Oozie是针对大数据处理的调度器,还要适合于现有的大数据处理框架的功能。

Oozie基本概念

基本架构是Oozie客户端(命令行或REST接口)去提交job,给Oozie服务器,通过服务器中的调度器去调度job在Hadoop上执行,因此在Oozie上有一个做相应大数据的库。此外还有一个针对工作流引擎的数据库,存储工作流细节,这是关系型的数据库。 右侧是客户端提交任务的详细情况,客户端将job上传到HDFS上,集群上的所有节点能够通过HDFS下载job的详细信息,之后,job被提交到yarn集群上,MR,Hive,Pig,Java,Shell,Sqoop,SSH做支撑。

Oozie流程

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

Oozie是解决工作流,特别是大数据处理工作流的任务框架。

工作流的必要性

第一点是在大数据处理中需要创建端到端的应用,经常处理一些定时、调度、shell脚本将流程化的节点串接在一起,如果使用传统的方式也就是脚本,但是效率比较底下,无法可视化的对脚本处理,以及相应的脚本的错误处理、通知、其他的监控通知无法做到自动化,而且不同的步骤之间的逻辑以及精细化的调度也很难做精细化的处理。所以说,我们需要在大数据工作流引擎,去支撑这种应用。 第二点如果自己做一些Spark脚本,需要通过一系列的提交,这个工作效率是非常低的。之所以为什么不模拟Spark客户端去提交信息,是因为数据处理任务仅仅是写一个处理函数,相关的步骤框架是通过Oozie满足的。这也是大数据工作引入的必须的条件。Oozie是针对大数据处理的调度器,还要适合于现有的大数据处理框架的功能。

Oozie基本概念

基本架构是Oozie客户端(命令行或REST接口)去提交job,给Oozie服务器,通过服务器中的调度器去调度job在Hadoop上执行,因此在Oozie上有一个做相应大数据的库。此外还有一个针对工作流引擎的数据库,存储工作流细节,这是关系型的数据库。 右侧是客户端提交任务的详细情况,客户端将job上传到HDFS上,集群上的所有节点能够通过HDFS下载job的详细信息,之后,job被提交到yarn集群上,MR,Hive,Pig,Java,Shell,Sqoop,SSH做支撑。

Oozie流程

详细学习内容可观看Spark快速大数据处理扫一扫~~~或者引擎搜索Spark余海峰

编译

编译需要占用很大的内存,只创建一个app-11即可。

1、以hadoop用户登录。

命令:su – hadoop

2、在tmp目录下创建Oozie编译文件。

命令:mkdir /tmp/oozie

3、进入tmp根目录下。

命令:cd /tmp/

4、下载Spark-stack。

命令:git clone https://github.com/haiye1018/Spark-stack.git

5、进入Spark-stack/Oozie/目录下。

命令:cd Spark-stack/Oozie/

6、将buildOozie目录下的文件拷贝到Oozie编译文件中。

命令:cp buildOozie/* /tmp/oozie/

7、进入Oozie编译目录下。

命令:cd /tmp/oozie/

8、下载Oozie编译包。

命令:wget https://archive.apache.org/dist/oozie/5.0.0/oozie-5.0.0.tar.gz

9、解压。

命令:tar -xf oozie-5.0.0.tar.gz